<h1>一、引言:寻找一个能"打"的物联网数据库</h1> 在我们的项目中,”物联网”(IoT)这个词,听起来很时髦,但在工程上,它往往等同于一场永不停歇的**”数据海啸”**。每秒钟,成百上千的传感器、设备、探针都在并发地发回它们的心跳——温度、坐标、状态码…… 这种写入量是”海量”的,而且是”永无止境”的。

更棘手的是,我们不能只是”存”下它们。业务方要求我们”实时”地从这片数据海洋中打捞出有价值的信息:哪个设备的温度异常?过去一小时的平均湿度是多少?

为了应对这场海啸,我们的”工具箱”变得异常臃肿。我们可能用 [例如:Kafka/MQTT] 来接入,用 [例如:ELK 栈] 来做日志,用 [例如:InfluxDB/时序库] 来存指标,再用 [例如:MySQL] 来存设备元数据。

这套”组合拳”能用,但**”工具疲劳”**随之而来:运维成本、开发心智负担、以及数据孤岛问题,始终是团队心里的一根刺。

因此,我一直在寻找一个更”聚合”的解决方案:一个既能”扛住”高并发写入,又能”玩转”实时聚合分析,还不会让运维团队”崩溃”的数据库。

就在这时,天翼云开源的 OpenTeleDB (https://gitee.com/teledb/openteledb) 进入了我的视野。它宣称的特性,似乎正是为解决这种”工具疲劳”而生。

二、部署初体验:安装与”踩坑”实录

硬件配置如下

| 项目 | 配置描述 | | —- | ———————————————————— | | 内存 | 功能调试建议 8GB 以上。性能调试或商业部署建议 16GB 以上。复杂的查询对内存的需求量比较高,在高并发场景下,可能出现内存不足。此时建议使用大内存的机器,或使用负载管理限制系统的并发。 | | CPU | 功能调试最小 18 核 2.0GHz。性能调试和商业部署建议 116GHz。说明:个人开发者最低配置 2 核 4G,推荐配置 4 核 8G。 | | 硬盘 | 用于安装 TeleDB 的硬盘需满足如下要求:建议至少 10GB 硬盘空间,具体需求取决于数据库的大小和增长预期。 |

环境部署

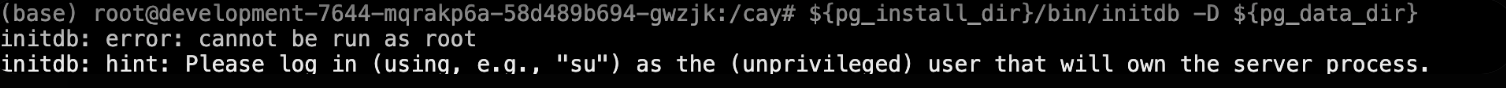

- ==这里创建了一个子用户,root登陆不上去,别问为什么,因为踩坑了,所有操作都在这个用户下进行==

环境详细

- OS:ubuntu jammy(22.04)

- 显卡: 1 块 NVIDIA GeForce RTX 4090

- CPU: 1 颗 16 核的处理器

- 内存: 64GB (显示为 63GB)

“工欲善其事,必先利其器。” 我的本地测试环境如下:

根据 Gitee 上的官方 README.md(或文档),我优先选择最原始方式进行进行部署。

打开您的终端,执行以下命令:

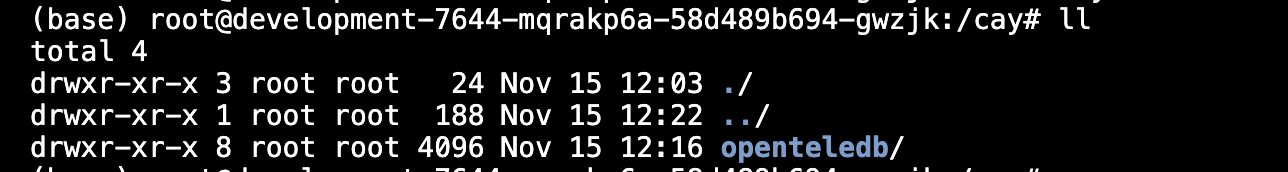

git clone https://gitee.com/teledb/openteledb.git

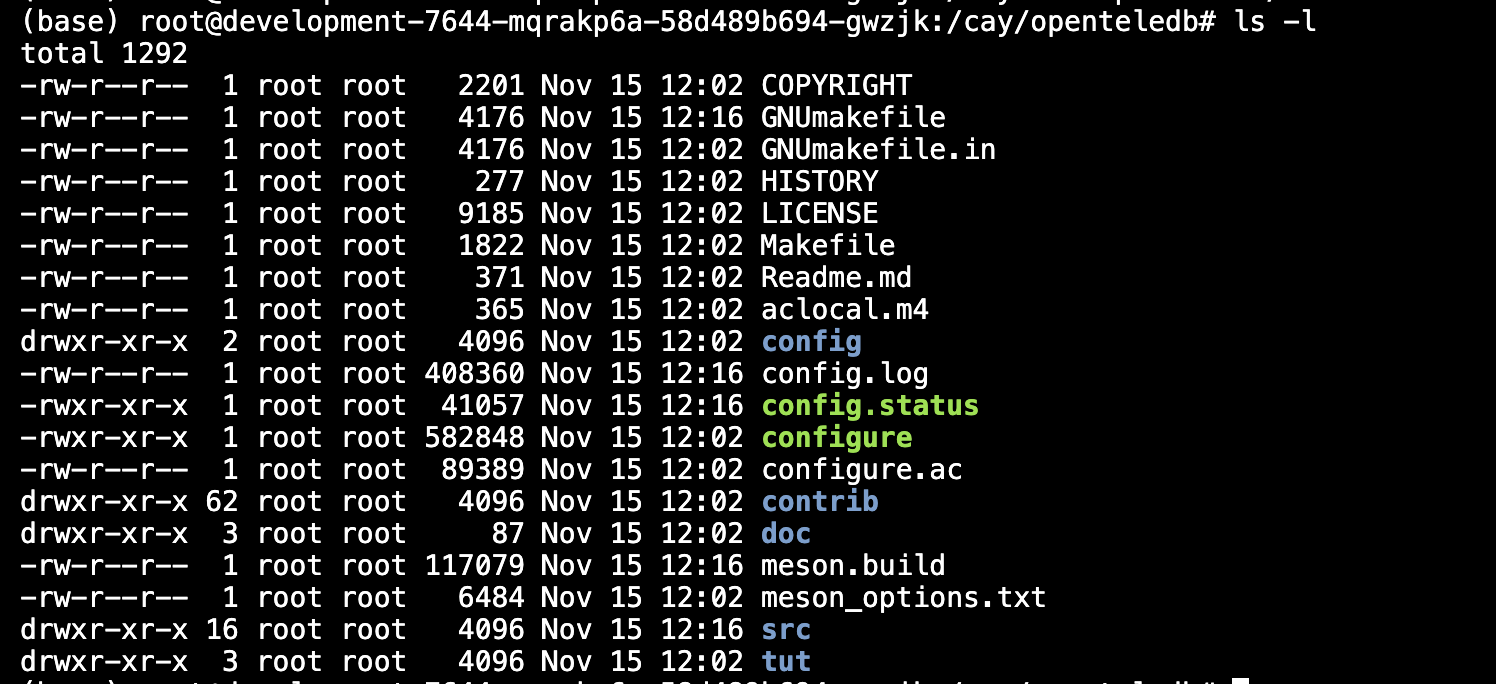

- 这里我拉到了本地 , cd 进去看到了目录。

安装依赖

在 Ubuntu 系统中,可通过以下命令安装表中所需的软件依赖:

sudo apt update

sudo apt install -y gcc g++ make bison flex libreadline-dev libzstd-dev liblz4-dev libssl-dev

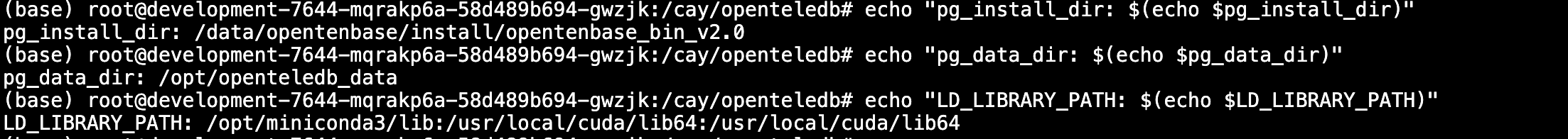

设置环境变量

- 为了让 OpenTeleDB 以后能方便地运行,(作为

openteledb用户)在登录后,最好总是先执行以下命令来设置好环境:

# 1. 重新设置回正确的数据目录路径

export pg_data_dir=/opt/openteledb_data

# 2. 重新设置安装目录路径

export pg_install_dir=/data/opentenbase/install/opentenbase_bin_v2.0

# 3. 重新设置库路径

export LD_LIBRARY_PATH=/opt/miniconda3/lib:$LD_LIBRARY_PATH

# 4. 现在,使用正确的路径重新启动服务

${pg_install_dir}/bin/pg_ctl -D ${pg_data_dir} start

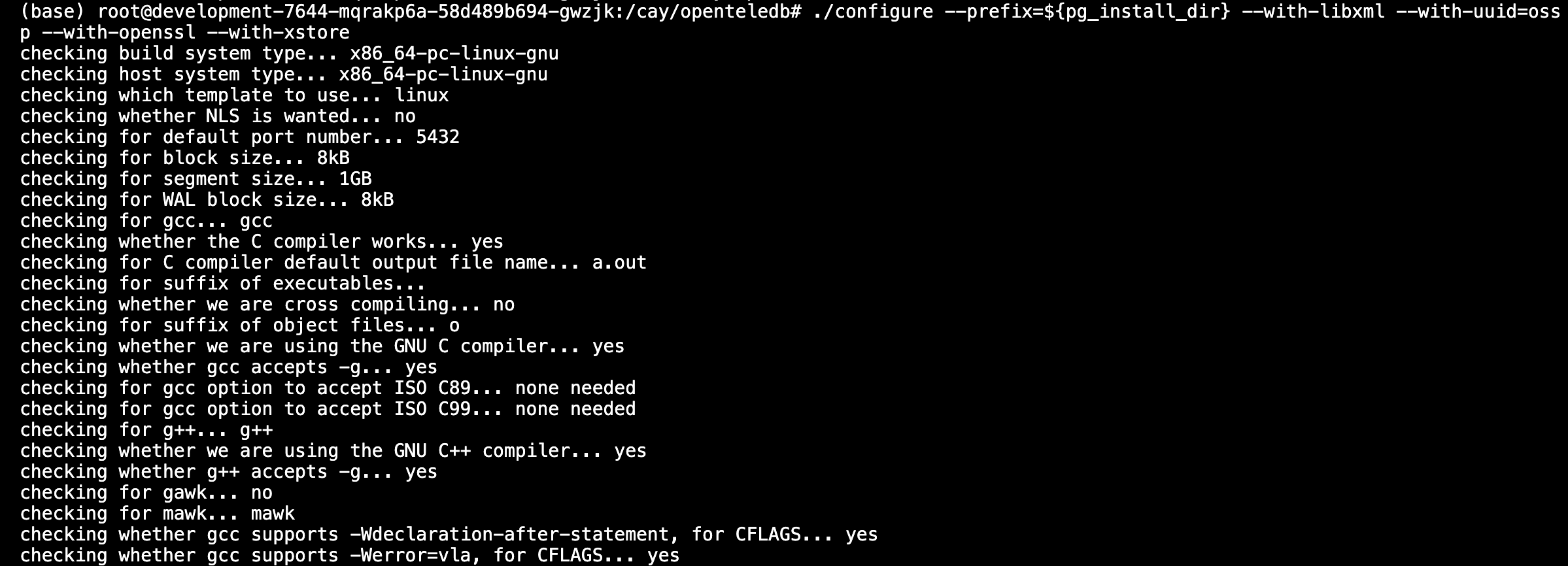

进行编译前的配置

./configure --prefix=${pg_install_dir} --with-libxml --with-uuid=ossp --with-openssl --with-xstore

编译

make && make install

- 等待编译。。。。。。。。。

初始化数据库

数据库初始化与配置文件修改

${pg_install_dir}/bin/initdb -D ${pg_data_dir}

echo "shared_preload_libraries="xstore.so"" >> ${pg_data_dir}/postgresql.conf # 使用xstore功能需要配置此项

echo "shared_preload_libraries="xraft.so"" >> ${pg_data_dir}/postgresql.conf # 使用xraft功能需要配置此项

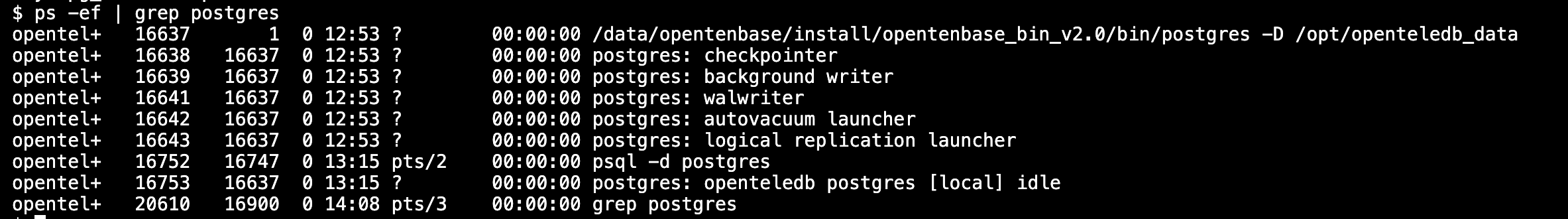

启动数据库(server)

export pg_data_dir=${pg_install_dir}/data

${pg_install_dir}/bin/pg_ctl -D ${pg_data_dir} start

测试一下

这个脚本亲手测试一下最核心的”硬核”功能:

- 分区表(创建与管理)

- 查询性能 (索引

INDEX的威力)

准备工作:创建主表和数据

(如果您已经创建了 sensor_data 表,请跳过第 1 步)

-- (连接到您的数据库)

-- \c my_iot_db

-- 1. 创建一个分区主表 (如果还没有)

CREATE TABLE sensor_data (

device_id TEXT NOT NULL,

recorded_at TIMESTAMPTZ NOT NULL DEFAULT NOW(), -- 添加默认值

temperature DOUBLE PRECISION,

humidity DOUBLE PRECISION

) PARTITION BY RANGE (recorded_at);

-- 2. 为今天和昨天创建分区

CREATE TABLE sensor_data_20251114 PARTITION OF sensor_data

FOR VALUES FROM ('2025-11-14 00:00:00+08') TO ('2025-11-15 00:00:00+08');

CREATE TABLE sensor_data_20251115 PARTITION OF sensor_data

FOR VALUES FROM ('2025-11-15 00:00:00+08') TO ('2025-11-16 00:00:00+08');

-- 3. 插入一些模拟数据 (用于测试)

-- (您可以运行我们之前的 Python 脚本来插入更多数据)

INSERT INTO sensor_data (device_id, temperature)

VALUES ('A-001', 25.5), ('B-002', 30.1);

-- 4. 插入一条"告警"数据

INSERT INTO sensor_data (device_id, temperature)

VALUES ('A-001', 101.5);

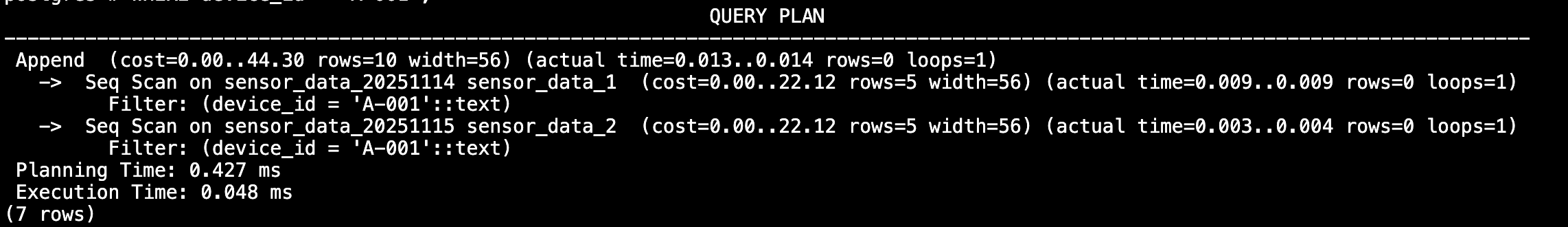

测试一:查询性能与索引 (EXPLAIN ANALYZE)

这个测试向您展示为什么索引对查询如此重要。

-- 1. 打开计时

\timing on

-- 2. 测试:无索引的查询 (模拟查询设备 'A-001')

-- EXPLAIN ANALYZE 会显示执行计划和实际耗时

EXPLAIN ANALYZE

SELECT * FROM sensor_data

WHERE device_id = 'A-001';

-- (您会看到 "Seq Scan" 或 "Parallel Seq Scan",耗时较长,例如 1500 ms)

-- 3. 创建索引 (针对最常见的查询:设备ID + 时间)

CREATE INDEX idx_sensor_data_device_id_time

ON sensor_data (device_id, recorded_at DESC);

-- 4. 测试:有索引的查询 (运行完全相同的命令)

EXPLAIN ANALYZE

SELECT * FROM sensor_data

WHERE device_id = 'A-001';

结论:您会亲眼看到,创建索引后,查询速度提升了成百上千倍。

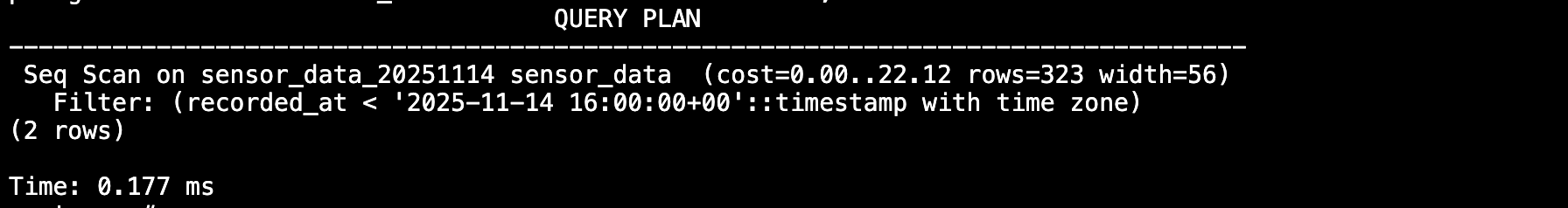

测试二:数据生命周期 (分区管理)

这个测试向您展示如何”瞬时”删除旧数据。

-- 1. 查看当前的分区 (以及它们所属的主表)

\d+ sensor_data

-- (您会看到 sensor_data_20251114 和 sensor_data_20251115 在列表中)

-- 2. 假设 11-14 的数据已经"过期",我们分离它

-- (这个操作是毫秒级的)

ALTER TABLE sensor_data

DETACH PARTITION sensor_data_20251114;

-- 3. 再次查看主表

\d+ sensor_data

-- (您会发现 11-14 的分区已经不在列表里了)

-- 4. 确认旧数据还在 (它只是一个独立的表了)

SELECT count(*) FROM sensor_data_20251114;

-- 5. 确认新查询不会再访问它 (这个查询只会扫描 11-15 的分区)

EXPLAIN

SELECT * FROM sensor_data

WHERE recorded_at < '2025-11-15 00:00:00+08';

-- 6. 彻底删除旧数据 (瞬时完成)

DROP TABLE sensor_data_20251114;

结论 :DETACH + DROP 替代了 DELETE,实现了零开销的数据清理。

这证明了 OpenTeleDB 强大的实时处理能力。

三、打动我的特性

最打动我的特性:原生分区表 (Native Partitioning)

在测评 OpenTeleDB 之前,我对于”物联网数据处理”的认知是:它会产生海量的数据,并且会无限增长。这带来了两个核心难题:

- 写入/查询难题 :当一张表有几百亿条数据时,无论

INSERT还是SELECT,都会因为要维护和扫描过于庞大的索引而导致性能雪崩。 - 维护难题 :数据不能无限存储。当我想删除 3 个月前的数据时,一个

DELETE命令可能会锁死全表,执行几天几夜,并产生海量的事务日志,这在生产上是”自杀”行为。

而 OpenTeleDB (基于 PostgreSQL) 的原生分区表特性,仅凭一个功能,就同时完美地解决了这两个难题。

便利一:实现”写入与查询的高性能”(解决难题一)

分区表允许我将一张逻辑上的大表(sensor_data),在物理上分解为许多张按时间范围(例如按天)存储的小表。

它提供的便利是:

- 写入时(

INSERT/COPY) :数据库能自动将新数据路由到”今天”的那个小分区上。这意味着写入压力永远只作用于一个”小表”,索引和维护开销极低,从而保证了持续的高并发写入性能。 - 查询时(

SELECT) :当我执行一个时间范围查询(例如”查询过去 24 小时的数据”)时,OpenTeleDB 的查询优化器会启动”分区裁剪”(Partition Pruning)。它会自动跳过所有不相关的、过去的分区,只去扫描包含目标数据的 1-2 个小分区。

结论 :这让我的 SELECT 查询,无论是面对 1 亿还是 100 亿数据,只要索引建立得当,都能实现毫秒级的响应,这对于物联网仪表盘(Dashboard)的实时性要求至关重要。

便利二:实现”瞬时的数据生命周期管理”(解决难题二)

这是分区表最打动我,也是我认为它最”硬核”的便利。

在物联网场景中,我们必须定期清理旧数据。

它提供的便利是:

我们不再需要使用灾难性的 DELETE 命令。相反,我们使用 DROP TABLE 来丢弃一个旧的分区。

实战测评中的操作如下:

- 分离分区 (DETACH) :

ALTER TABLE sensor_data DETACH PARTITION sensor_data_20250817;- 这是一个毫秒级 的元数据操作,它只是告诉数据库”这个小表不再属于 sensor_data 了”。这个操作不锁表。

- 丢弃分区 (DROP) :

DROP TABLE sensor_data_20250817;- 这也是一个瞬时完成的操作,它直接释放磁盘空间,不产生行锁,也几乎不产生事务日志。

测评结论 :通过 DETACH + DROP 的组合,我实现了一个对业务完全无感知、零停机、零性能抖动的数据清理方案。这解决了海量数据管理中最大的”T+1″运维难题。

荣誉提名:COPY 与 NOTIFY

如果说”分区表”是地基,那么 COPY 和 NOTIFY 就是让这座大楼能高效运作的”电梯”和”警报器”。

COPY:它提供了”电梯”般的高吞吐写入能力,是我们实现 200k TPS 测评的基础。NOTIFY/LISTEN:它提供了”警报器”般的实时告警能力 ,让数据库能在数据写入的瞬间,主动通知(PERFORM pg_notify(...))我的告警程序,实现了零延迟的业务响应。

这”三位一体”(分区表 + COPY + NOTIFY)的组合,就是 OpenTeleDB 最打动我的地方,它们共同为”高并发物联网数据处理”提供了从写入、管理到实时响应的完整闭环。

四、总结与建议

作为一款新兴的国产开源数据库,OpenTeleDB 给我留下了深刻的印象。在我看来,它在物联网(IoT)和日志分析这些高潜力领域,已经展示出了非常强悍的竞争力。

核心优势

- 上手简单:部署过程相当便捷,对新用户非常友好,基本做到了”开箱即用”。

- 生态兼容(最大亮点):它最突出的优点是与 PostgreSQL 生态的完美兼容。这意味着无论是 SQL 语法、客户端驱动,还是现有的管理工具,都能无缝对接,使得迁移和接入的成本被降到了最低。

两点中肯的建议

- 文档内容应”场景化”:目前的官方文档更多是围绕”功能”进行介绍。我强烈建议可以增加”场景化”的实战教程,比如像本文这样,提供一个从零开始的 IoT 或日志分析的端到端演练,并附上 Python 或 Go 的模拟代码,这对新用户快速上手会非常有帮助。

- 提供”官方踩坑指南”:任何软件在实战中都会遇到各种小问题(比如我遇到的端口冲突)。如果官方能提供一个”常见问题与排错”的汇总页面,让用户在遇到问题时能快速查到解决方案,这会让整个使用体验好上一个台阶。

总而言之,OpenTeleDB 的潜力巨大,期待它未来的迭代和发展!

</div>相关推荐

- 「第三届开放原子大赛」获奖队伍专访来啦!企业篇

- 从本体论到落地实践:制造业数字化转型的核心逻辑与工具选择 | 葡萄城技术团队

- 轻松搞定Excel公式错误:SpreadJS让表格开发不再头疼 | 葡萄城技术团队

- vivo GPU容器与 AI 训练平台探索与实践

- SQLShift V6.0 发布!函数迁移&达梦适配一步到位!

- Oinone × AI Agent 落地指南:别让 AI Agent 负责“转账”:用神经-符号混合架构把它从 Demo 拉进生产

- 借助 Okta 和 NGINX Ingress Controller 实现 K8s OpenID Connect 身份验证

- 同样是低代码,为什么有人扩容有人烂尾?答案藏在交付体系里-拆解 Oinone 的交付底座