<p style="margin-left:0; margin-right:0"><span>作为我国最早的大型铁路勘察设计单位之一,</span>中铁第一勘察设计院(以下简称“铁一院”) 在沙漠铁路、高原冻土铁路、高地温岩土工程处理、长大干线隧道、高寒地区高铁设计等复杂、艰巨的项目中积累了大量宝贵经验。但随着人才迭代,传统 “师徒传承” 模式下的知识流失、效率低下等问题愈发突出,亟待破局。

传统师徒传承模式,给知识的传承、经验的迁移、数据的利用带来 三大难题 :

-

知识不易传承

-

经验不易迁移

-

数据难以挖掘

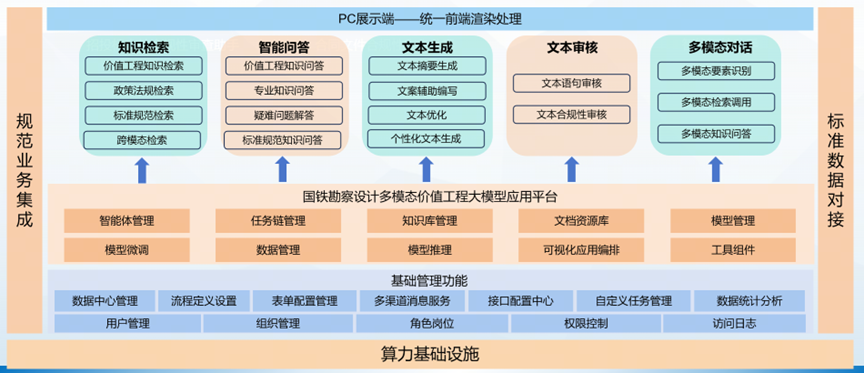

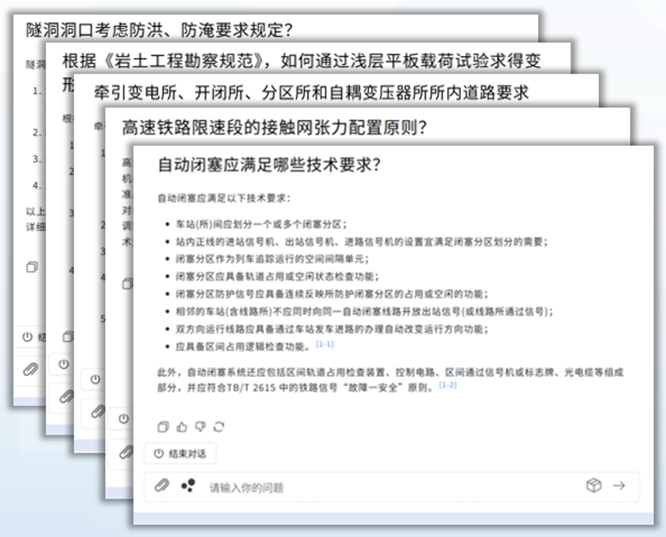

为了找准痛点,对症下药, 商汤大装置与铁一院打造 国铁价值工程多模态大模型应用平台 ,首次将多模态大模型应用于铁路工程设计知识的智能传承与应用。 依托商汤大模型应用开发框架 LazyLLM ,商汤大装置为勘察设计人员打造了国铁勘察设计知识检索、知识问答、文本生成、文档审核以及多模态对话等功能,减轻报告撰写工作量,提高审核效率与质量,助力勘察设计工作 “全程提效” 。这相当于为每个技术员工引入一个集几十年经验为一身的权威专家!

LazyLLM 技术亮点

LazyLLM 是专为下一代AI应用设计的数据流驱动型开发软件,通过独创的Pipeline/Parallel/Loop等数据流引擎,让开发者以积木式拼装构建多Agent应用(如智能对话、多模态RAG、AIGC工具)。

📌Github主页

https://github.com/LazyAGI/LazyLLM

01. 灵活性高

自由编排 RAG 召回策略和Agent执行算法,助力开发者像搭乐高玩具一样轻松组件个性化应用。

02. 产品落地快

利用自定义的轻量网关机制,帮助用户将单个demo快速转化为可用产品。

03. 普适性强

统一市面诸多大模型调用接口,基模型自由切换,为用户提供一致的使用体验。

04. 直观简洁

精细化模块设计,符合直觉的代码风格帮你集中精力,打造爆款产品。

LazyLLM 在本次项目中的技术点梳理

1. 多学科、多模态的数据治理与知识库构建

🗝️ 定制化数据治理管道

铁路工程勘察设计领域覆盖 28 个专业,数据包含法律法规、标准规范、项目成果等,总规模超 420 GB,其中文本类超 130 GB。LazyLLM 团队基于各专业的语料特性,设计专属文档处理 Pipeline,将自定义切片策略(Transform)与节点分组策略(Node Group)以可插拔方式嵌入,兼顾跨专业的一致性与专业内的个性化。

🗝️

高密度知识场景的稳定与扩展

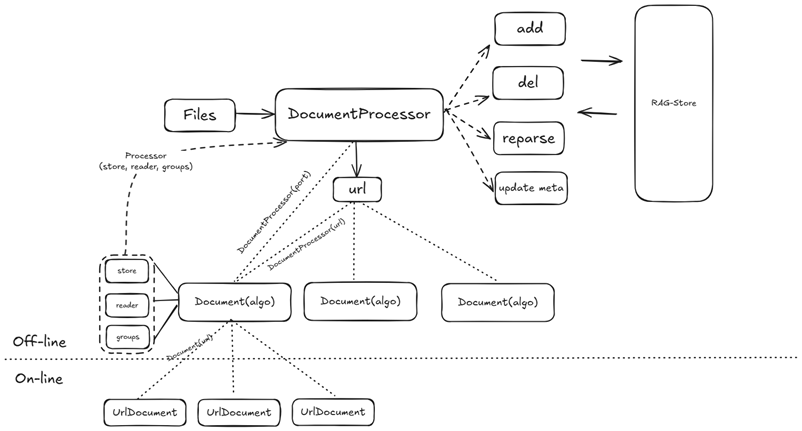

面对学科多样、知识极度密集的场景,对存储与检索的稳定性、可扩展性要求极高。LazyLLM 内置文档管理服务的 DocProcessor 具备高扩展解析能力,能覆盖海量文件并行处理;同时深度适配商汤自有高性能存储系统,为知识库问答提供稳定、低延迟、可横向扩展的检索底座。

LazyLLM天然支持高可扩展的文档解析服务

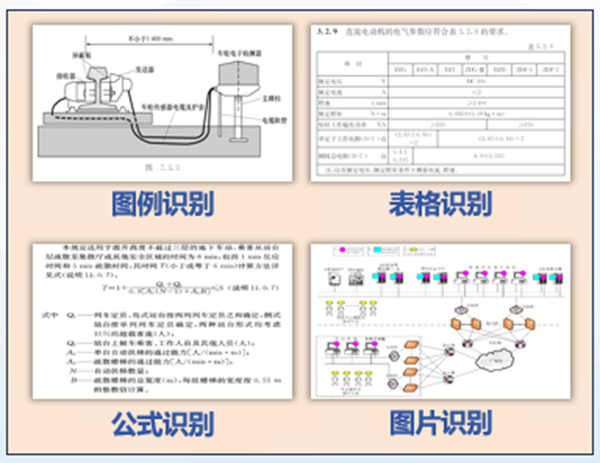

🗝️跨模态文档解析与向量表征

铁路知识同时存在图片、表格、公式与文本等多模态形态。LazyLLM 原生适配高性能解析组件

MinerU

,对版面、图片、公式、表格进行结构化抽取;文档管理组件支持

多向量模型混用

,算法可按模态自适应选择合适的嵌入模型,提升特征表征多样性,显著拓展多模态知识的可检索覆盖面。

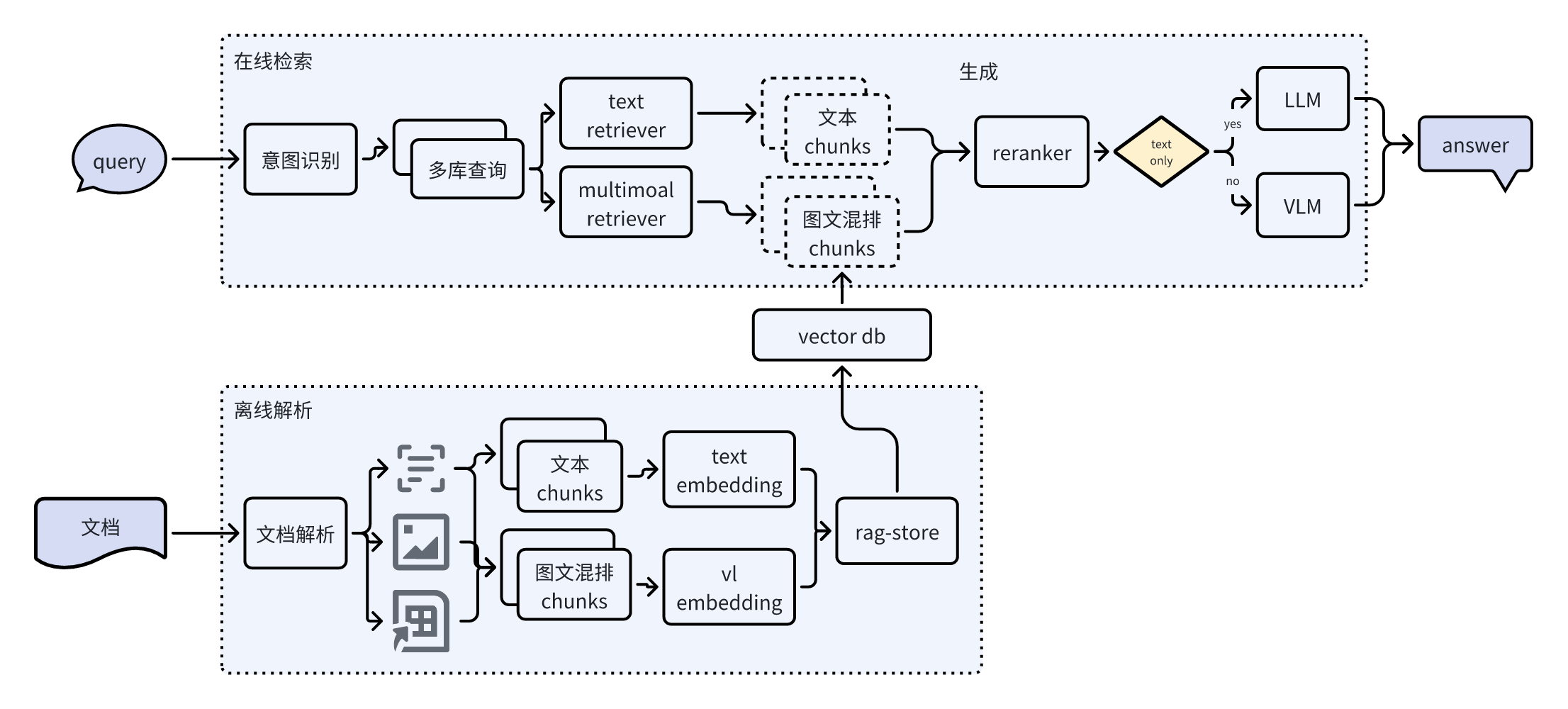

2. 多模态知识问答(RAG)能力

🗝️

面向行业的 RAG 全链路适配

围绕知识治理—检索—生成全链路,LazyLLM 设计并实现行业化的 RAG 算法,兼顾专业严谨性与可解释性,满足铁路工程勘察设计领域的高标准问答需求。

🗝️

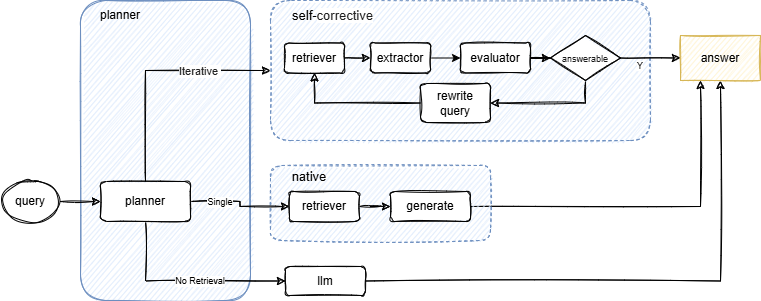

面向复杂任务的 Multi-Agent RAG

针对多跳推理与跨模态复杂问题,引入多角色协作的 Multi-Agent RAG:通过阶段化检索、证据评估与噪声过滤,结合推理模型优势,显著提升复杂问题的正确率与可追溯性。

🗝️

面向演进的模块化迭代机制

依托 LazyLLM 的 Flow 组件,研发流程遵循「Pipeline 搭建 → 模块迭代 → 数据回流」闭环。各环节支持“无痛”替换与灰度升级,便于在不影响主流程的前提下快速验证与上线更优策略。

3. 智能写作 + AI 审核:

把专家时间还给高价值工作

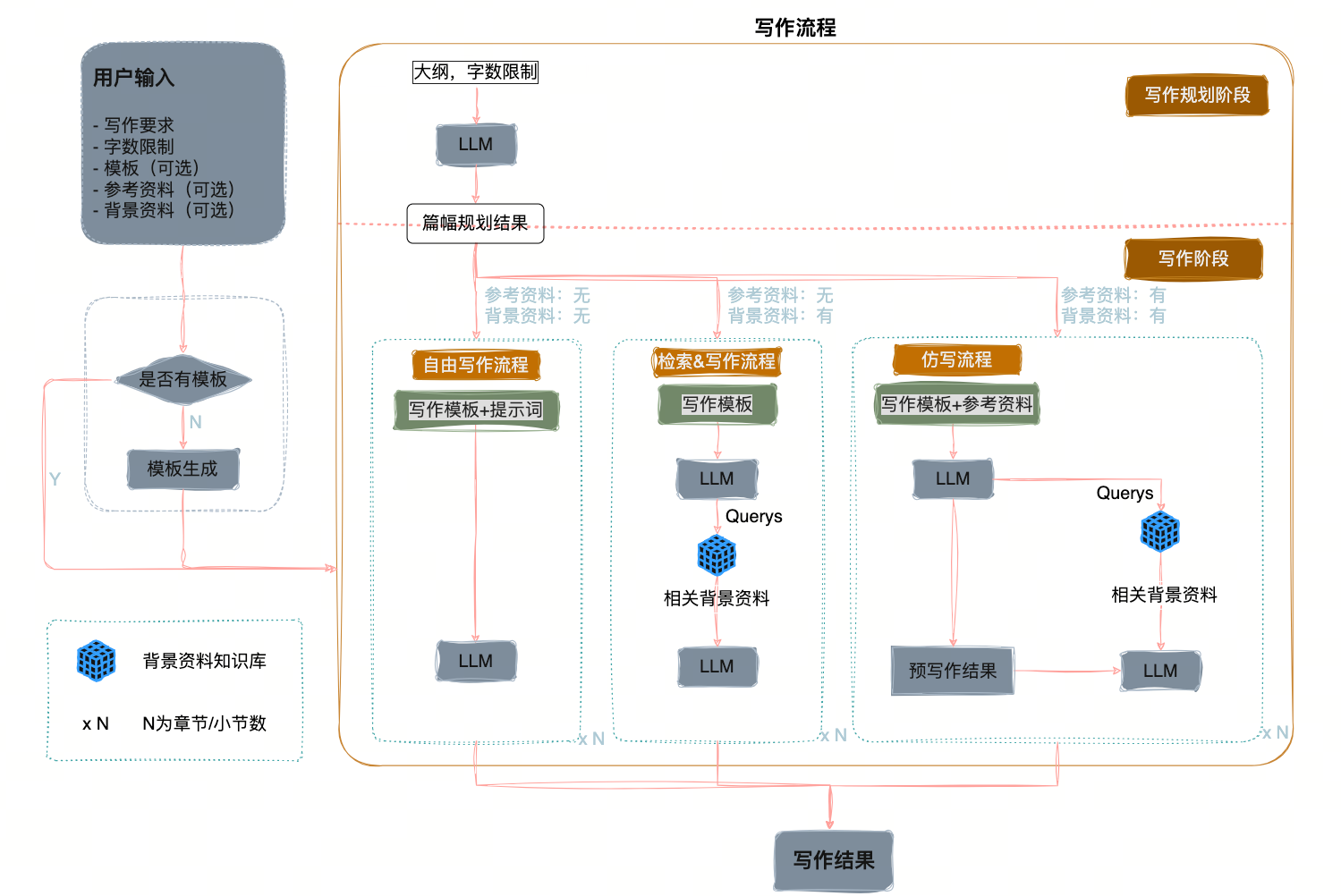

日常工作并不只需要问答。围绕铁路专家的真实痛点,团队基于 LazyLLM 编排了两类多智能体应用,面向「 长文写作 」与「 专业审核 」两个高耗时场景:

🗝️智能写作 Agent(深度检索 + 结构化生成)

通过深度搜索 Agent 与写作 Agent 的协作,采用「多阶段检索 + 两阶段生成」流程:

-

基于工程信息与专业模板生成多维大纲;

-

融合价值工程知识库迭代扩写;

-

生成符合专业要求的长篇高质量报告。

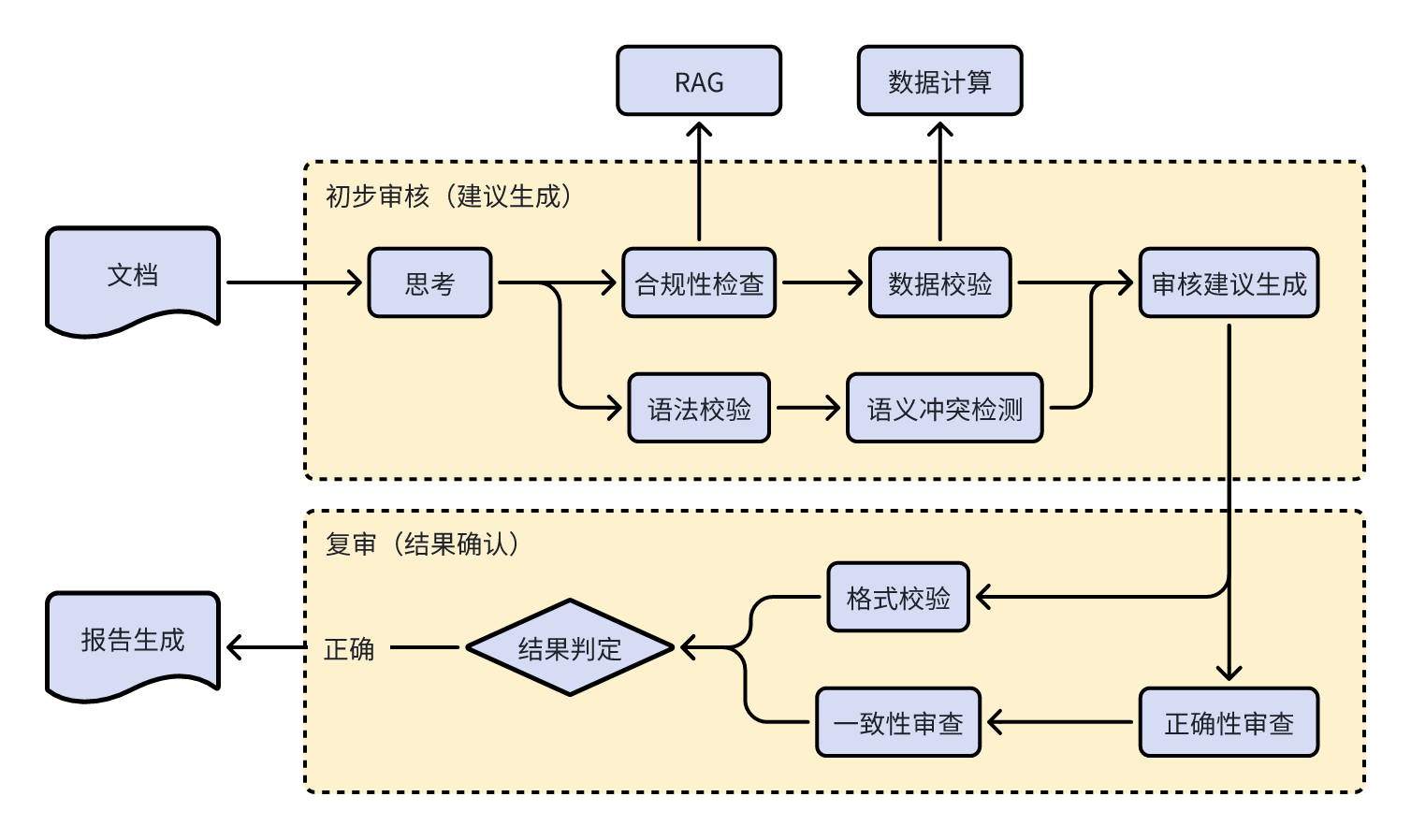

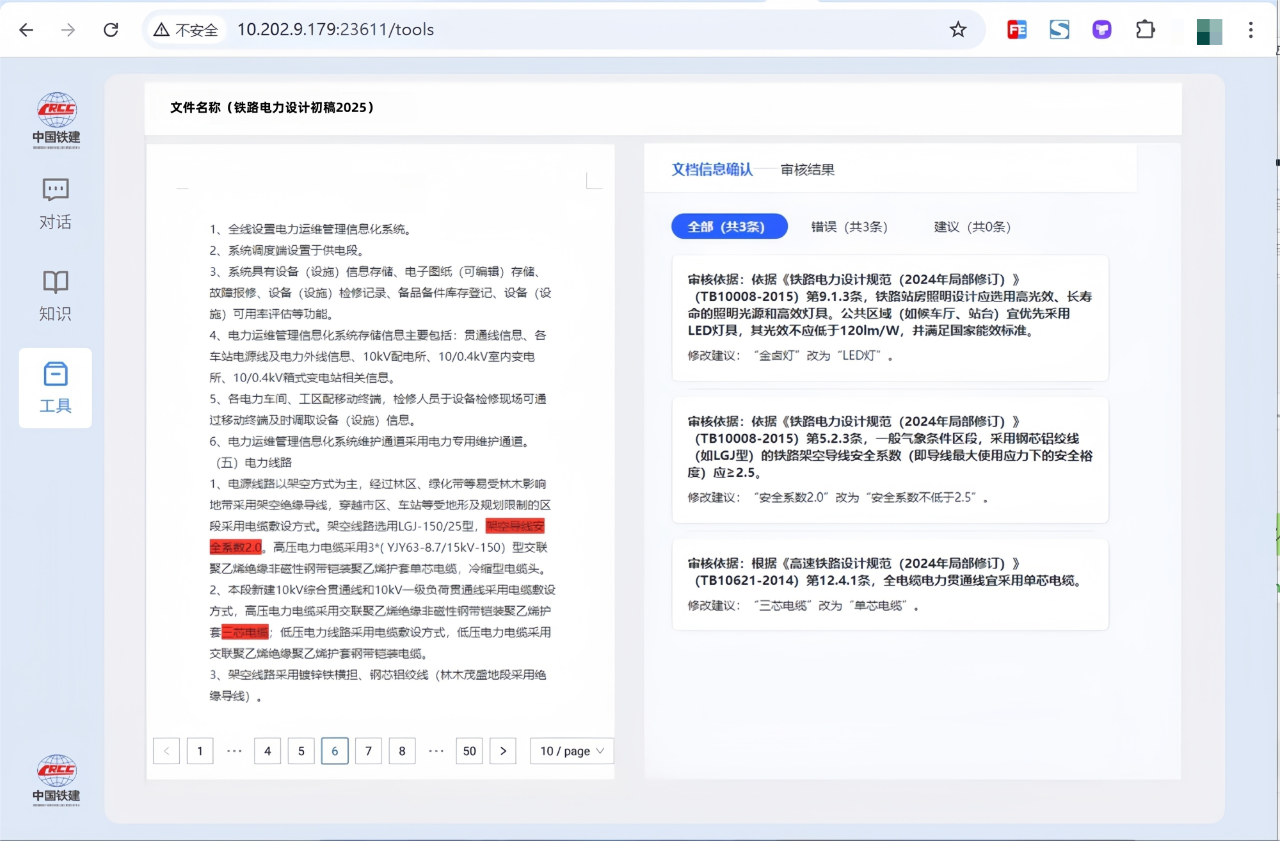

🗝️AI 审核 Agent(规则/计算/检索三引擎协同)

面向多专业报告审核,内置

规则引擎、计算引擎、检索引擎

:除术语与标点等基础校验外,重点支持

跨专业一致性校验

,并实现

审核结论

—

证据链

同步展示,保障结果可解释、可追溯、可落地。

以铁一院项目为起点,LazyLLM 已经在 「多学科、多模态、强治理」 的高要求环境中验证了可扩展的知识底座与可进化的智能体工作流。它既能把碎片化、异构化的行业知识沉淀为结构化资产,又能以模块化方式持续升级 RAG 与写作/审核能力,将专家从重复性工作中解放出来,把时间投入到更具价值的工程决策与创新实践中。

面向未来,LazyLLM将继续

围绕跨模态检索优化、复杂推理增强、多智能体应用场景拓展、系统工程优化等

方向稳步演进,让行业大模型应用在可靠、可控的路径上持续创造真实业务价值!

更多技术交流,欢迎移步“LazyLLM”gzh!

</div>相关推荐

- 「第三届开放原子大赛」获奖队伍专访来啦!企业篇

- 从本体论到落地实践:制造业数字化转型的核心逻辑与工具选择 | 葡萄城技术团队

- 轻松搞定Excel公式错误:SpreadJS让表格开发不再头疼 | 葡萄城技术团队

- vivo GPU容器与 AI 训练平台探索与实践

- SQLShift V6.0 发布!函数迁移&达梦适配一步到位!

- Oinone × AI Agent 落地指南:别让 AI Agent 负责“转账”:用神经-符号混合架构把它从 Demo 拉进生产

- 借助 Okta 和 NGINX Ingress Controller 实现 K8s OpenID Connect 身份验证

- 同样是低代码,为什么有人扩容有人烂尾?答案藏在交付体系里-拆解 Oinone 的交付底座