<p>Data + AI 已经成为数据从业人员必须关注的技能。在基于 Databend Cloud 平台上可以大大简化数据人员在数据基础工作方面的投入,让数据人员可以花更多的精力去研究 Data + AI 的实践。在此背景下,11月29日,Databend Meetup·上海站线下活动"如何打造 AI 时代的数据基石",汇集了国内数据库领域多位一线专家:<strong>Databend 创始人吴炳锡、沉浸式翻技术专家陈琦,沈超、资源数据平台架构师邵锋、TiDB</strong> <strong>解决方案架构师</strong> <strong>刘源、空中云汇架构师赵飞祥</strong>以及来自各行各业的技术负责人,数据部门负责人。参会嘉宾围绕"如何打造 AI 时代的数据基石"的主题,共同探讨了大模型时代数据库和数据平台的创新演进与实战应用。</p>

以下内容就将为您带来这些话题背后的深度思考:

基于 Databend 无编程实 Data Pipeline 及数据分析

Databend Labs 联合创始人吴炳锡,系统地介绍了 Databend 作为一款云原生数据仓库,如何以其独特架构和技术特性,极大地简化和革新传统大数据 Data Pipeline 的构建与数据分析流程,并展示了其与 AI 融合的强大潜力。

Databend 的清晰定位:解决传统大数据之痛

分享开宗明义,指出了 Databend 的核心定位:简单易用、高性能、低成本。其目标是成为一款云原生湖仓一体化产品,旨在:

- 降低云上大数据成本:利用对象存储实现极致的存算分离和低成本存储。

- 简化数据架构:坚持” SQL 为王”,让复杂的湖仓开发变得像使用传统数据库一样简单。

- 统一数据枢纽:支持构建企业级统一数据仓库,并提供跨多云、跨 IDC 的高可用体验。

核心革新:重构 Data Pipeline 的开发模式

分享通过对比,深刻剖析了传统大数据架构(依赖 Kafka, Flink, Spark, Trino 等繁多组件)的痛点:技术栈复杂、技术要求高、落地慢、运维成本高昂。

针对这些痛点,Databend 提出了一套以 SQL 为中心 的”无编程” Data Pipeline 解决方案,其核心构件包括:

- 数据秒级摄入 (

COPY INTO+External Stage):通过监听对象存储事件,实现海量数据的快速加载与可见。 - 内置流计算 (

Stream):提供表级增量变更捕获能力,无需额外组件即可实现高效的实时 ETL,性能提升可达 10 倍。 - 自动化任务调度 (

Scheduled Task):通过 Serverless Task 实现完整的数据处理工作流编排,让一个懂 SQL 的人就能轻松完成复杂的数据治理。 - 强大的外部函数 (

UDF):支持用 Python 等语言轻松扩展功能,实现与外部系统(如更新 Redis)或 AI 服务的无缝集成。

与 AI 的深度融合:从数据平台到智能基座

分享重点展示了 Databend 在 AI 时代的前瞻性,其与 AI 的融合体现在两个层面:

- 原生 AI 能力:内置向量计算和 AI 函数(如

cosine_distance),为 AI 应用提供开箱即用的支持。 - 可扩展的 AI 集成 (

External UDF):通过 UDF 可以方便地调用 Embedding 模型、情感分析、文本相似度等外部 AI 服务,将 Databend 升级为一个支持智能化数据分析与应用的” AI 原生”平台。

卓越效益与广泛验证

分享通过具体数据证明了 Databend 的卓越效益:

- 成本大幅降低:在替换 Trino/Presto、Elasticsearch、数据归档等场景中,成本降低 75% 到 95%。

- 极致的可扩展性:支持单表 2.6 万亿行、1PB+ 的超大规模数据处理。

- 广泛的行业应用:已成功服务于中信银行、微盟、苹果中国等知名企业,应用于主数据平台、日志分析、数据归档等多种场景。

总结

Databend 通过其云原生、一体化的架构,将复杂的大数据技术栈简化为以 SQL 为核心的开发体验,从根本上降低了数据开发的门槛、成本和运维负担。 它不仅是一个高性能的数据仓库,更是一个内置了流处理、任务调度和强大扩展能力的数据平台操作系统。在 AI 时代,其原生及可扩展的 AI 能力进一步使其成为企业构建智能化应用的理想数据基石,完美契合了当下企业追求降本增效和快速创新的核心诉求。

构建海量记忆:基于 Databend 的 2C Agent 平台|沉浸式翻译

沉浸式翻译团队技术专家陈琦在 构建海量记忆:基于 Databend 的 2C Agent 平台|沉浸式翻译实践分享,核心阐述了他们如何利用 Databend 构建一个面向海量用户的、具备”长期记忆”能力的 AI Agent 平台。

沉浸式翻译在比较早期已经接入 Databend , 公司内部在无运维的情况下,支撑了千万级用户,月活百万级用户。Databend 目前不但承担沉浸式翻译的平台分析数据,也承担了部分业务类数据。 目前团队正在 Databend 上构建海量记忆体的 2C Agent 平台。

核心挑战:

传统方案的痛点:

- 组件割裂:维护向量库、关系型数据库、缓存等多套系统,开发和运维复杂。

- 缺乏生命周期管理:向量库只增不减,导致噪音增加、性能下降、成本飙升。

为什么选择 Databend?

- All-in-One:统一处理向量、结构化和半结构化(JSON)数据,简化架构。

- Serverless:零运维、按需付费,完美契合小团队”小步快跑”的模式。

- 可编程性:通过 SQL、UDF 和 Task 实现复杂的数据处理和生命周期管理。大大简化开发投入

核心架构与创新(MemOS):

- MemNodes 表:作为记忆实体,利用计算列和聚簇索引优化混合查询(向量+条件过滤)性能。

- MemEdges 表:构建记忆图谱,用 SQL 存储关系,解决纯向量检索无法处理的逻辑推理问题。

- 混合检索算法:结合 SQL 过滤、向量搜索和图关联,实现精准且上下文丰富的记忆召回。

- 自动化生命周期:通过 Serverless Task 定期对记忆进行摘要融合和归档,实现”会遗忘的智能系统”。

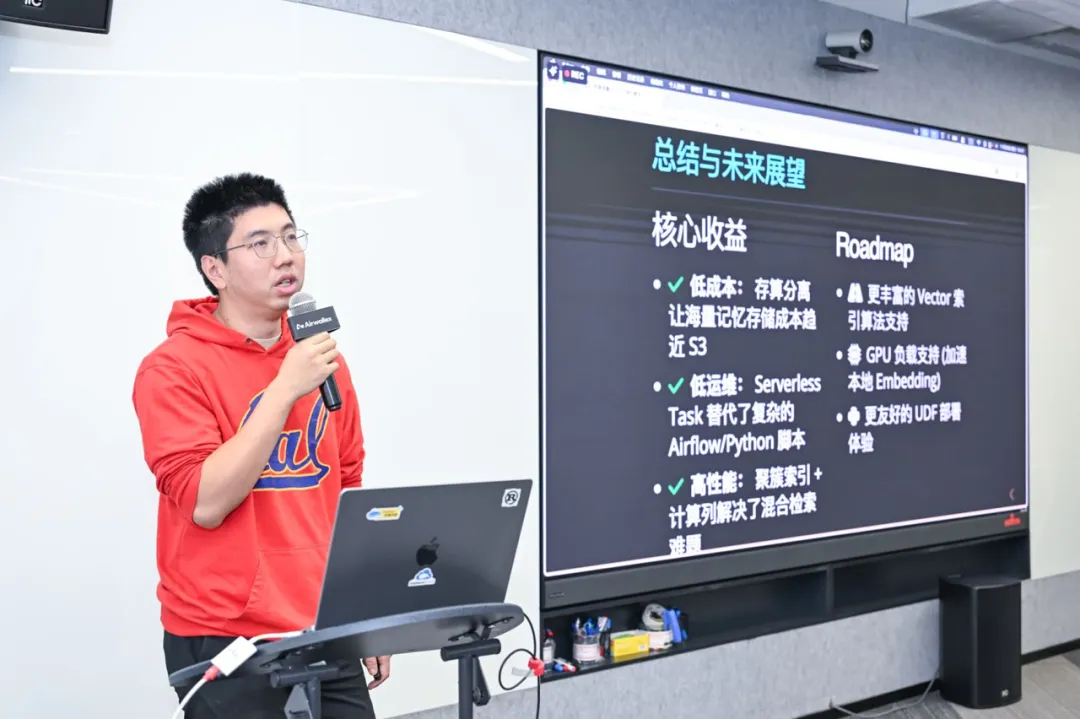

价值总结:

该实践成功地将 Databend 作为统一数据基石,以极低的运维成本和优雅的技术方案,实现了从”翻译工具”到懂用户的”语言伴侣”的演进,为 2C AI 提供了易用,低成本,高性能的平台。

Data + AI – 数据平台的应用和实践

第三个分享中邵锋老师带着一线经验给我们分享数据平台的建设和 Data+AI 实践。属于非常硬核的分享,因为保密问题就不再公开邵锋老师的分享。

AI 时代的数据基石:趋势、挑战与 TiDB 实践

TiDB 解决方案架构师刘源老师,从行业更宏观的视角探讨了 AI 时代的数据挑战,并阐述了 TiDB 作为”数据基石”的解决方案和案例。

核心洞察:

- AI 发展趋势:大模型进入平台期,下一代突破指向”世界模型”。当前 AI 面临幻觉问题(源于概率生成的有损压缩)、算力消耗和伦理安全等挑战。

- AI 应用现状:情感陪伴、内容生成等”幻觉友好型”应用火热,但金融、制造、医疗等严肃 ToB 场景落地艰难,面临数据治理缺失、场景碎片化等挑战。

AI 时代对数据库的新要求:

- 多模态融合:同时处理关系表、向量、全文、图谱等数据,”多库合一”。

- 实时与高扩展:弹性支撑 Agent 的推理、记忆和 Multi-Agent 协作。

- 支持 AI 原生体验:成为 Agent 的”集体记忆中枢”,能主动交互。

TiDB 的解决方案:

-

核心特性:金融级高可用、天生的弹性扩展、HTAP 一体化架构、正在演进的多模态数据融合能力。

-

AI 原生探索:

- 增强数据访问层:通过 RAG、GraphRAG 等技术,将 TiDB 打造成企业知识核心,降低大模型幻觉。

- 构建 Data Agent 能力:研发 AutoFlow,让用户用自然语言直接进行混合查询和数据分析。

- 面向 Multi-Agent 未来:扮演”共同记忆体”,支持数据版本化、分支管理等。

相关推荐

- 「第三届开放原子大赛」获奖队伍专访来啦!企业篇

- 从本体论到落地实践:制造业数字化转型的核心逻辑与工具选择 | 葡萄城技术团队

- 轻松搞定Excel公式错误:SpreadJS让表格开发不再头疼 | 葡萄城技术团队

- vivo GPU容器与 AI 训练平台探索与实践

- SQLShift V6.0 发布!函数迁移&达梦适配一步到位!

- Oinone × AI Agent 落地指南:别让 AI Agent 负责“转账”:用神经-符号混合架构把它从 Demo 拉进生产

- 借助 Okta 和 NGINX Ingress Controller 实现 K8s OpenID Connect 身份验证

- 同样是低代码,为什么有人扩容有人烂尾?答案藏在交付体系里-拆解 Oinone 的交付底座