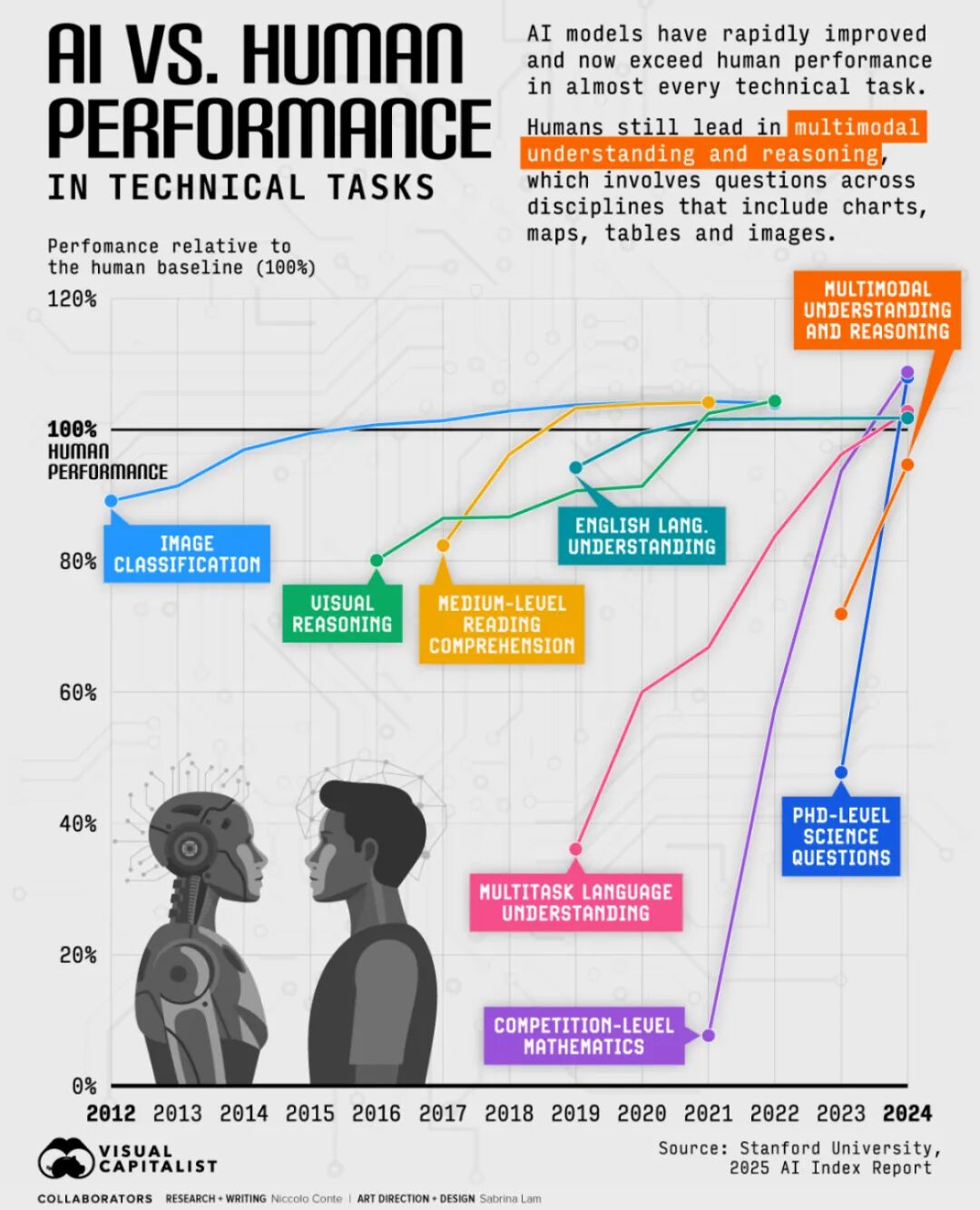

AGI虽在实际应用中仍存局限性,但曙光现已成为今年行业的共识。在一系列技术任务中,从ChatGPT到Gemini,许多世界领先的AI 模型正超越人类基准线:据斯坦福大学《2025年AI指数报告》,AI已在7项测试中超越人类基准线,这些测试衡量的任务包括:图像分类、视觉推理、中等阅读理解、英语语言理解、多任务语言理解、竞赛级数学、博士级科学问题。

目前,AI系统唯一尚未赶上人类的领域是多模态理解与推理,而这项任务涉及跨多种格式和学科(如图像、图表、图解)进行处理和推理。不过,这一差距正在迅速缩小。

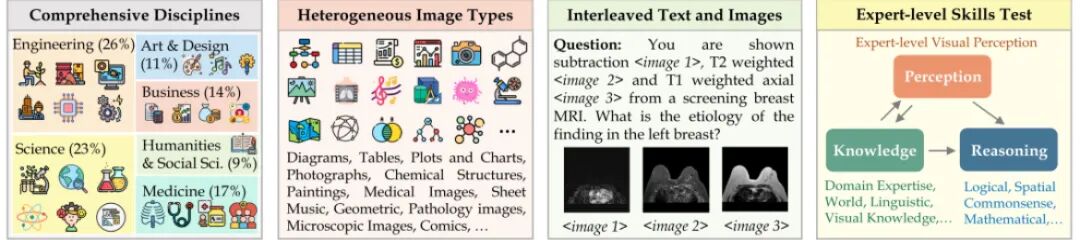

MMMU数据集的四大特性 —— 全面性:涵盖六个广泛学科领域与30个大学科目,包含1.15万个大学难度级别的问题;图像类型高度异质:包含极其多样化的图像类型;图文并茂:文本与图像交错混合,需要跨模态理解;专家级感知与推理:要求具备扎根于深厚学科知识的专家级感知与推理能力。

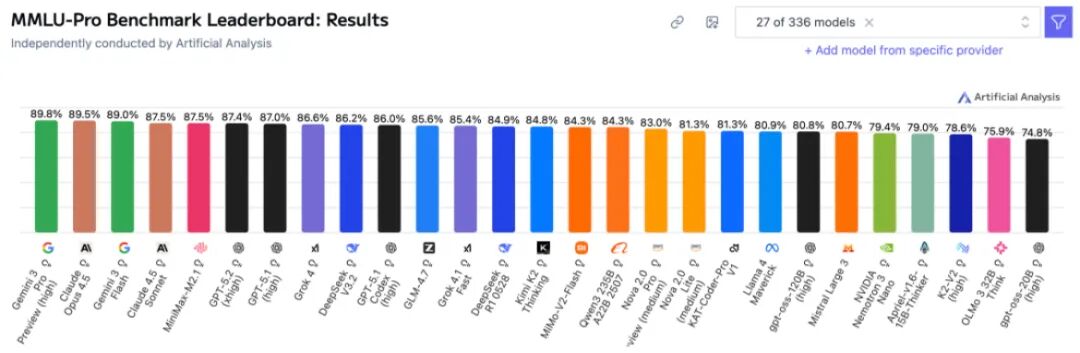

MMMU基准测试,是评估模型在需要大学学科知识的跨学科任务上的表现,目前此基准测试日益饱和。在2023年底,谷歌Gemini的得分仅为59.4%;到2024年,OpenAI的o1模型取得了78.2%的分数;今年,Gemini 3 Pro在增强版MMMU-Pro上取得了89.8%的得分。

令人瞩目的是,有研究者在3B参数模型上以低于30美元的成本复现了DeepSeek-R1-Zero的强化学习训练方案。通用人工智能测试基准ARC-AGI-1,最佳成绩超过近90%;ARC-AGI-2上,AI超过了人类平均水平。

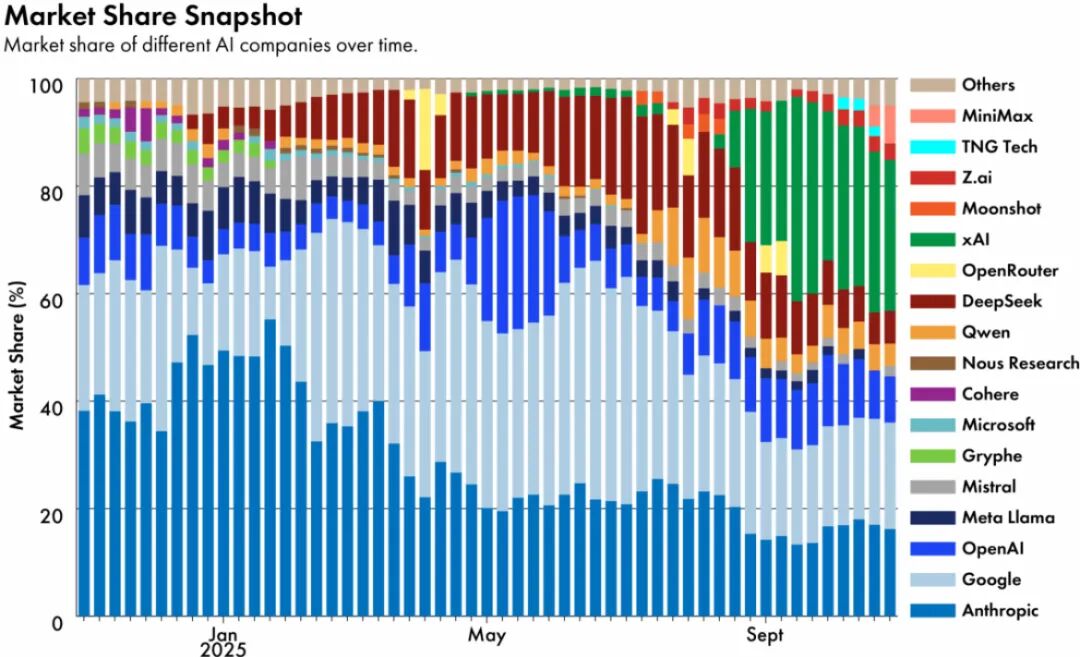

DeepSeek年度最大黑马

DeepSeek-R1成为历史上第一个通过同行评议的大模型,喜登Nature封面;创始人梁文锋入选Nature年度10大人物。对比中国开源模型的崛起,Llama却彻底出局。

值得注意的是,Mamba虽然在理论上展现出潜力,在初期备受关注后逐渐淡出视野,在研究之外缺乏实际应用。Transformer模型已在硬件和软件层面深度优化,使得用未经验证的架构重新训练大型模型在经济上难以证明其合理性,特别是当结果与现有模型相当或更差时。成熟的Transformer软件生态系统带来了巨大的转换成本,且Mamba的固定状态内存无法选择性地检索被忽略的token。

而在计算机视觉领域,Vision Transformer是否已取代CNN的问题仍存在争议。显然Transformer在许多任务中越来越受青睐,并在大数据集上表现出色,但CNN和混合架构在小数据集、医学影像和特定领域仍具竞争力。不过,ConvNeXt是强有力的替代方案,Transformer需要更多内存且难以处理可变图像分辨率,数据集质量比架构选择更重要。

<!-- 非定向300*250按钮 17/09 wenjing begin --> <!-- 非定向300*250按钮 end -->

</div>