<!-- 正文广告top end -->

<!-- 引文 start -->

<!-- 引文 end -->

<!-- 正文 start -->

<div class="article" id="artibody" data-sudaclick="blk_content">2025年6月30日,华为正式宣布开源盘古7B参数的稠密模型、盘古Pro MoE 72B混合专家模型和基于昇腾的模型推理技术。随后一项由@HonestAGI 发布于GitHub的针对盘古大模型的研究引发业界热议,该研究的作者认为,华为推出的盘古大模型(Pangu Pro MoE)与阿里巴巴发布的通义千问Qwen-2.5 14B模型在参数结构上存在高相似度。

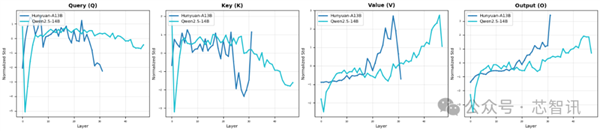

HonestAGI 通过测试比较称,Pangu Pro MoE模型与Qwen-2.5 14B模型在注意力参数分布上的平均相关性高达0.927,远超其他模型对比的正常范围(业内同类模型对比通常不超过0.7)。

由于深度学习模型的训练具有高度随机性,涉及复杂的数据采样、权重初始化及优化路径。两个模型在众多注意力参数上呈现近乎一致的分布,其自然发生的概率极低。因此,这种极高的相似度,立即引发其涉嫌“抄袭”的质疑。

随后,有自称是盘古大模型团队的人在GitHub上进行了回应,否认抄袭指控,并且认为该作者的评估方法不科学。

该用户表示,使用论文中描述的方法,评估了以下模型比较:

pangu-72b-a16b vs. Qwen2.5-14b = 0.92baichuan2-13b vs. Qwen1.5-14b = 0.87baichuan2-13b vs. pangu-72b-a16b = 0.84baichuan2-13b vs. Qwen2.5-14b = 0.86

可以看到不同其他相近参数规模的模型在该评估方法下也得到了与Qwen-2.5 14B模型高度相似的结果。这表明该论文和指标缺乏实际意义。盘古团队进一步并重申没有抄袭。

对于该回应,HonestAGI 表示,其无法信服盘古大模型团队的说法。HonestAGI 称,“盘古仍然显示出最高的相似度,对吧?我们很高兴看到您成功复现了我们的结果!事实上,任何分类问题都有一个阈值来识别决策边界(例如,本例中疑似值为0.9)。这主要是一个用于初步比较的工具,而盘古‘不幸地’在我们开始进一步调查之前触发了这个警告信号。我们并非仅仅基于注意力参数就做出判断。这只是动机。……”

随后,HonestAGI 还提供了 Qwen 和 Hunyuan A13B 之间的比,结果显示二者在不同层级上展现出截然不同的内部模式,这表明它们拥有截然不同的架构和学习到的表征。显然,HonestAGI提供该对比数据是想说明其测试方法没有问题。

不过,目前HonestAGI似乎已经下线了之前关于盘古大模型的研究报告。但是,HonestAGI 在最新的回应中表示,“我们计划在论文最终定稿并提交所有代码后,将其提交给同行评审会议(可能是 ICLR 或之后的会议?)。”

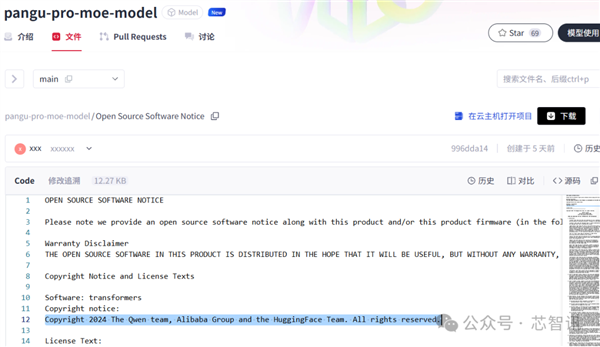

另外,值得注意但是,通过查询盘古大模型团队官方发布在国内代码托管平台Gitcode(类似国外的Github)的“盘古Pro”大模型代码,可以发现其“’Open Source Software Notice”当中的赫然出现了关于“transformers”组件的版权声明“Copyright notice:Copyright 2024 The Qwen team, Alibaba Group and the HuggingFace Team. All rights reserved.” 显然这段说明的意思是,其所用到的“transformers”组件的版权所有人是Qwen团队、阿里巴巴集团和HuggingFace团队。

需要指出的是,该代码是由“Ascend Tribe”——盘古大模型团队官方发布,并不是其他第三方进行发布的。由此也有不少网友认为这是“实锤”抄袭的证据。

不过,业内人士表示,这是一份标准的开源声明,当盘古大模型团队使用了第三方开发的开源软件时,根据开源许可要求,是必须需要向用户说明的法律义务。而在这份声明当中,只能表明盘古大模型当中用了阿里巴巴Qwen团队 和 HuggingFace共同开发的“transformers”组件,并且使用的是“Apache License 2.0”协议。该协议它允许任何人自由地使用、修改和分发该软件,甚至用于商业产品中。所以,这份声明只反应了盘古大模型团队用了一些开源代码,并且遵守了开源协议,并不能证明抄袭。

盘古大模型团队正式回应

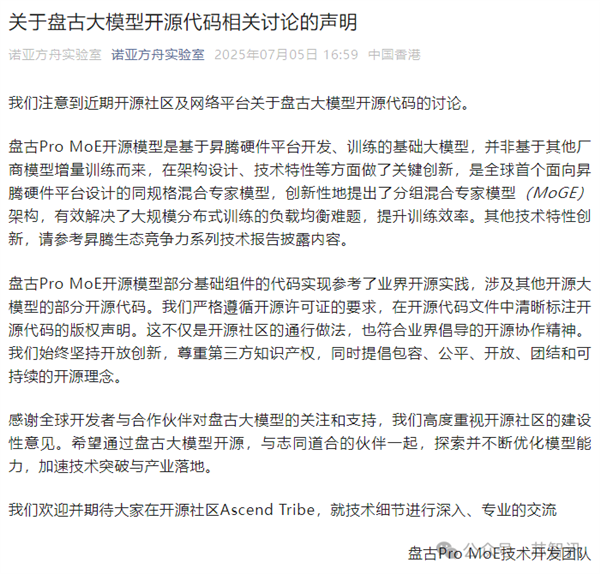

7月5日下午16:59分,隶属于华为的负责开发盘古大模型的诺亚方舟实验室发布声明对于“抄袭”指控进行了官方回应。

诺亚方舟实验室表示,盘古Pro MoE开源模型是基于昇腾硬件平台开发、训练的基础大模型,并非基于其他厂商模型增量训练而来,在架构设计、技术特性等方面做了关键创新,是全球首个面向昇腾硬件平台设计的同规格混合专家模型,创新性地提出了分组混合专家模型(MoGE)架构,有效解决了大规模分布式训练的负载均衡难题,提升训练效率。

不过,诺亚方舟实验室也承认,“盘古Pro MoE开源模型部分基础组件的代码实现参考了业界开源实践,涉及其他开源大模型的部分开源代码。我们严格遵循开源许可证的要求,在开源代码文件中清晰标注开源代码的版权声明。这不仅是开源社区的通行做法,也符合业界倡导的开源协作精神。我们始终坚持开放创新,尊重第三方知识产权,同时提倡包容、公平、开放、团结和可持续的开源理念。”

此外,芯智讯发现,有百度贴吧网友爆料称,负责盘古大模型的开发的诺亚方舟负责人王云鹤在内网也针对此事做了回应,回应内容的核心是两个:1、盘古大模型是基于昇腾芯片进行训练的,与Qwen所用的训练硬件是不同的;2、盘古大模型当中所使用的Llama和Qwen的组件都是已经开源的,并不是抄袭。

总结来看,目前尚无证据证实盘古大模型存在抄袭阿里Qwen的“实锤”证据,HonestAGI 所发布的质疑论文所采用的测试方法的可靠性也有待进一步验证,毕竟其并未完全公开其测试代码,更何况HonestAGI 已经下线了之前的质疑论文。至于盘古大模型当中确实有采用Qwen的开源代码,但这部分的代码本就是开源代码,盘古大模型团队的相关的声明做法也是合规的,只能说盘古大模型并不是从零起步的绝对原创,如果只是用了部分开源组件,也并不属于抄袭。

文章内容举报

]article_adlist–>

<!-- 非定向300*250按钮 17/09 wenjing begin --> <!-- 非定向300*250按钮 end -->

</div>

<div class="article-bottom clearfix" id="article-bottom">

<!--通发页正文下方文字链广告 2022/12/29 王鑫 start-->

<div style="margin: 20px auto 15px; font-size:14px;">

<script>

(sinaads = window.sinaads || []).push({});

</script>

</div>

<div class="keywords" id="keywords" data-wbkey="盘古,华为,科技" data-sudaclick="content_keywords_p">

<label>关键词 : </label>

<a href="http://tags.tech.sina.com.cn/%E7%9B%98%E5%8F%A4" target="_blank">盘古</a> </div>

<!-- 新浪众测推广 start -->

<div class="blk-zcapp clearfix">

<a href="http://zhongce.sina.com.cn/about/app?frompage=doc" target="_blank">

<img class="zcapp1" src="http://www.zc91.cn/wp-content/uploads/2025/03/余承东称华为新机不止.png" title="新浪众测" alt="新浪众测">

<img class="zcapp2" src="http://www.zc91.cn/wp-content/uploads/2025/03/1742310425_107_余承东称华为新机不止.png" title="新浪众测" alt="新浪众测">

</a>

</div>

<!-- 新浪众测推广 end -->

<!-- 公众号二维码 start -->

<div class="blk-wxfollow clearfix">

<div class="wx-qr">

<img src="http://www.zc91.cn/wp-content/uploads/2025/03/1742310425_226_余承东称华为新机不止.png" title="新浪科技公众号" alt="新浪科技公众号">

</div>

<div class="wx-info">

<span>新浪科技公众号</span>

<p>“掌”握科技鲜闻 (微信搜索techsina或扫描左侧二维码关注)</p>

<img src="http://www.zc91.cn/wp-content/uploads/2025/03/1742310425_895_余承东称华为新机不止.png" alt="">

</div>

</div>

<!-- 公众号二维码 end --> <!-- 评论 start -->

<div class="blk-comment" id="wrap_bottom_omment">

<div id="bottom_sina_comment"></div>

</div>

<!-- 评论 end -->

<!--通发页评论下方文字链广告 2022/12/29 王鑫 start-->

<div style="margin: 20px auto -20px; font-size:14px;">

<script>

(sinaads = window.sinaads || []).push({});

</script>

</div>

<!-- 相关新闻/相关微博 start -->

<div class="blk-related clearfix" id="tab_related">

<div class="tab-related-wrap">

<div class="tab-related" id="tab_related_btn">

<a href="https://finance.sina.com.cn/tech/discovery/2025-07-07/javascript:;" id="tab01_btn01" class="cur" data-sudaclick="relativenews_tab_i">相关新闻</a>