<p>资料来源: <a href="https://www.oschina.net/action/GoToLink?url=https%3A%2F%2Fdeveloper.volcengine.com%2F" target="_blank">火山引擎-开发者社区</a></p> AI 训练和推理对存储系统的极致挑战

在 AI 浪潮中,大模型训练与推理正以前所未有的速度推动计算能力突破极限。从自动驾驶 PB 级数据洪流到生成式 AI 微秒级推理响应,算力竞速已成为科技前沿的焦点。而数据管理和访问性能,也已成为决定 AI 训练效率、推理速度的核心要素。传统文件存储在面对 AI 时代 “数据密集、并发密集、场景复杂” 的极致需求时,逐渐显露出力不从心的一面,成为制约 AI 算力释放的瓶颈。

性能与容量强绑定:资源利用率低下,成本飙升:传统公有云文件存储普遍采用“性能与容量线性绑定”的设计。文件系统的性能由已用容量和规格性能上限决定,无法独立调整。

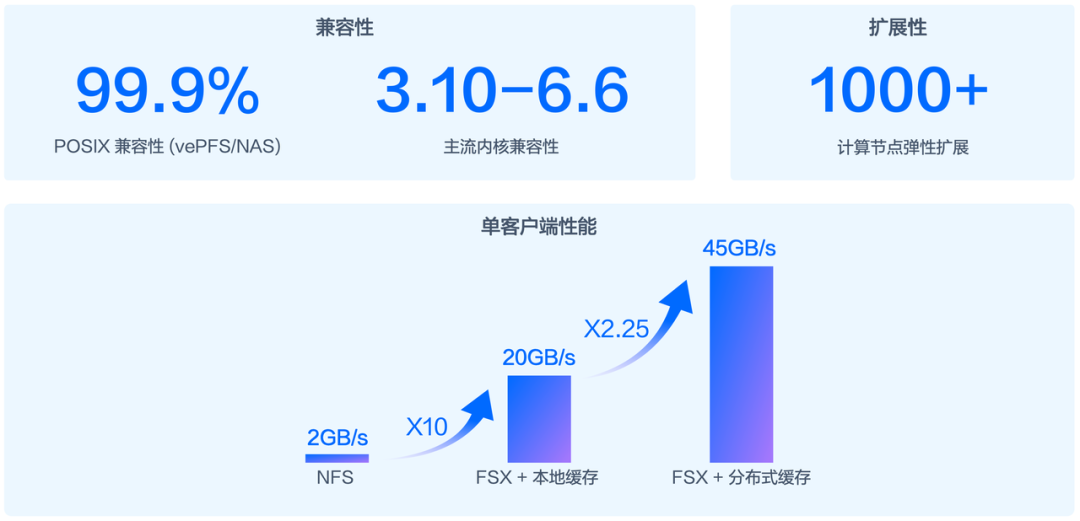

单客户端性能瓶颈明显:无法匹配 AI 算力,拖慢效率:传统 NFS 协议并未针对 AI 场景进行深度优化,单客户端读写带宽仅 2~3GB/s 左右,使得 GPU 算力无法得到充分利用,拖慢了训练进度。

缺乏智能数据流动能力:冷数据成本高,流转复杂:AI 业务中 80% 的冷数据(历史训练集、过期 Checkpoint)仅需长期留存,但传统存储难以高效管理:冷数据仍占用高性能存储,按高价计费,长期成本极高;低频介质脱离对象存储生态形成数据孤岛,且无法利用对象存储跨区域复制等优势;而数据迁移依赖人工,又会破坏业务连续性。

元数据管理能力弱:海量文件存储受限:传统文件存储对单实例文件数限制严格(多为 10 亿),无法承载 AI 场景的百亿级小文件(如自动驾驶的图像样本、NLP 的文本片段),被迫采用 “多卷拆分” 方案,增加数据管理复杂度。

面向 AI 云原生全新设计的高性能弹性文件存储

弹性文件存储(Elastic File Storage,EFS)是火山引擎推出的新一代云原生弹性文件存储服务,面向 AI 设计又兼顾传统 NAS 需求。它以标准的 POSIX 语义为基础,提供了面向 AI 业务场景的高性能文件存储客户端 FSX 和面向传统 NAS 场景的主流协议 NFSv3 和 NFSv4.1,能够无缝对接各类 AI 训推框架、操作系统和应用程序,为用户提供与本地文件系统一致的使用体验。EFS 在保留传统 NAS 产品优势的基础上又提供了新的竞争力。

性能与容量彻底解耦:按需配置,极致弹性

EFS 重新定义了文件存储性能交付模式,支持按需配置文件系统访问性能,实现性能与容量解耦,彻底打破 “容量绑定性能” 的行业桎梏,让性能调度如弹性算力般灵活。

EFS 提供了两种核心带宽模式,并辅以突发带宽功能,为用户提供了前所未有的性能配置灵活性:

- 基线带宽模式: 为具有基本性能要求的工作负载提供可随存储容量扩展的带宽。在这种模式下,用户仅需为存储容量付费,性能会根据已用容量线性增长,直到达到规格性能上限为止。例如,EFS 高级型在基线带宽模式下,最大支持 30GB/s 带宽和 90 万 IOPS。

- 预置带宽模式: 彻底实现了性能与容量的解耦。用户可以根据实际业务需求,自定义文件系统预置带宽,无需考虑已用容量。用户仅需为超出基线带宽的部分付费。该模式支持高达 2TB/s 的读带宽和 3000 万 IOPS 的性能上限,能够满足 AI 推理场景小容量大吞吐以及模型训练场景大吞吐读写的极致性能需求。

- 突发带宽: 当工作负载需要临时(不可预测)使用更高的性能时,可以通过启动突发带宽功能获取临时的额外带宽。该功能默认为关闭状态,开启后可动态获取集群空闲带宽资源,性能随负载压力自动伸缩。计费仅覆盖超出基线带宽与预置带宽的部分,实现弹性成本控制。该功能最大支持突发到 200GB/s 读带宽。

自研高性能客户端:20+ 倍性能提升,释放极致算力

火山引擎自研的 FSX 客户端,基于自研类 FUSE 架构,为 EFS 提供了更高效、更智能的访问方式,真正做到了 AI 级客户端性能。

- 性能突破:通过优化数据传输算法和缓存机制,单客户端吞吐能力提升至 8GB/s,开启客户端缓存后单客户端吞吐能力更是高达 45GB/s,完美匹配 AI 训练等大带宽需求场景。

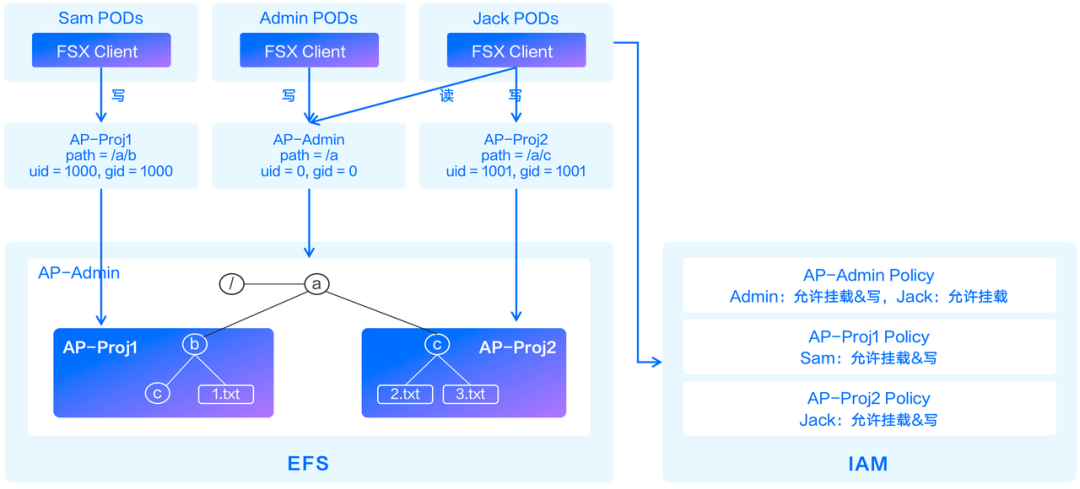

- 细粒度权限:FSX + EFS 接入点 + IAM 鉴权联动实现了目录级用户权限控制,满足多团队共享存储时的安全隔离需求。

智能双向数据流动:性能与成本的完美平衡

EFS 通过与火山引擎对象存储 TOS 的深度集成,实现了数据在文件存储和对象存储之间的智能双向流动,从而在保障极致性能的同时,大幅降低存储成本。

EFS 提供了预热、沉降、淘汰自动化策略及一次性任务:

- 预热:可将 TOS 中的增量数据自动加载至 EFS,为即将到来的高频访问做好准备,保障数据访问的低延迟和高吞吐。

- 淘汰:将 EFS 中的冷数据自动或手动沉降至 TOS 后删除数据块,EFS 中仅保留元数据,数据则存储在 TOS 中,极大节省 EFS 的存储空间。

- 按需加载:通过按需加载(lazy load),可从 EFS 透明访问已淘汰至 TOS 的冷数据。当应用尝试访问这些数据时,系统会自动将数据块从 TOS 加载至 EFS,对上层应用完全透明。

- 沉降:将 EFS 中的数据自动或手动迁移至 TOS,保留数据副本或实现数据迁移。

- 双向同步:EFS 支持与 TOS 之间的数据双向更新自动同步,提供数据的一致性保障。

千亿级文件数支撑:无感知扩展的存储底座

AI 训练依赖的数据集往往由海量小文件构成,例如自动驾驶的图像样本、NLP 的文本片段、多模态的音视频切片等。这些数据集的文件数可能轻松达到百亿甚至千亿规模。EFS 支持从 0 到 10 亿,再到千亿文件数的存储管理能力,为 AI 业务提供“无感知扩展”的存储底座。

- 扩展性:EFS 元数据集群支持横向扩展,文件数可以从 10 亿到千亿透明扩展,同时线性提升元数据处理性能。这意味着无论 AI 数据集规模如何增长,EFS 都能提供无缝的扩展能力,无需用户进行复杂的数据迁移或分片操作。

- 均衡性:EFS 元数据集群支持智能负载均衡,动态平衡 inode(索引节点)存储位置,智能调度元数据访问请求。这确保了在海量文件和高并发元数据操作场景下,系统性能的稳定性和高效性,避免了热点问题。

计算生态深度融合:端到端解决方案,加速业务落地

EFS 是火山引擎 AI 生态的重要组成部分,与机器学习平台(MLP)、容器服务(VKE)深度融合,共同为 AI 训推业务提供了端到端的解决方案。

- 与机器学习平台协同优化:火山引擎机器学习平台(MLP)为 AI 开发者提供了从数据处理、模型开发、训练到部署的全流程服务。EFS 作为 MLP 的底层存储,为其提供了高性能、高弹性的数据存储能力,确保 MLP 上的 AI 任务能够高效运行,加速模型从开发到生产的周期。

- 与容器服务深度融合:在云原生 AI 开发中,容器化部署已成为主流。EFS 与 VKE 的深度融合,使得容器应用可以轻松挂载 EFS 文件系统,实现数据的持久化和共享。这对于需要动态伸缩的 AI 训练任务和推理服务至关重要。

总结

在 AI 大模型训练与推理的算力竞速时代,存储性能已成为决定训推效率的核心引擎。火山引擎全新推出的弹性文件存储(Elastic File Storage,EFS),专为 AI 训推场景深度优化,以单实例千亿文件数、10PB 容量、TB/s 级吞吐和千万级 IOPS 的极致性能,支撑数万节点分布式训练的并发访问;创新性实现性能与容量解耦,预置带宽模式 + 突发带宽功能让性能调度如算力般灵活;智能数据流动功能打通对象存储,双向传输,冷热分层直降 70% 存储成本;搭配自研 FSX 客户端,单端缓存性能飙升至 45GB/s,完美承接高速数据访问需求。从自动驾驶 PB 级数据处理到生成式 AI 微秒级推理,EFS 让每次数据交互都成为算力加速燃料,重新定义 AI 训推效率上限。

</div>相关推荐

- 「第三届开放原子大赛」获奖队伍专访来啦!企业篇

- 从本体论到落地实践:制造业数字化转型的核心逻辑与工具选择 | 葡萄城技术团队

- 轻松搞定Excel公式错误:SpreadJS让表格开发不再头疼 | 葡萄城技术团队

- vivo GPU容器与 AI 训练平台探索与实践

- SQLShift V6.0 发布!函数迁移&达梦适配一步到位!

- Oinone × AI Agent 落地指南:别让 AI Agent 负责“转账”:用神经-符号混合架构把它从 Demo 拉进生产

- 借助 Okta 和 NGINX Ingress Controller 实现 K8s OpenID Connect 身份验证

- 同样是低代码,为什么有人扩容有人烂尾?答案藏在交付体系里-拆解 Oinone 的交付底座