C++

更多 >-

- MFC程序怎么重新启动?

-

精彩回放

7648人感兴趣

-

- libcurl返回HTTP状态码

-

精彩回放

9040人感兴趣

-

- c++实现按行读取文本文件

-

精彩回放

8084人感兴趣

-

- 如何安装 PHP-CPP

-

精彩回放

8493人感兴趣

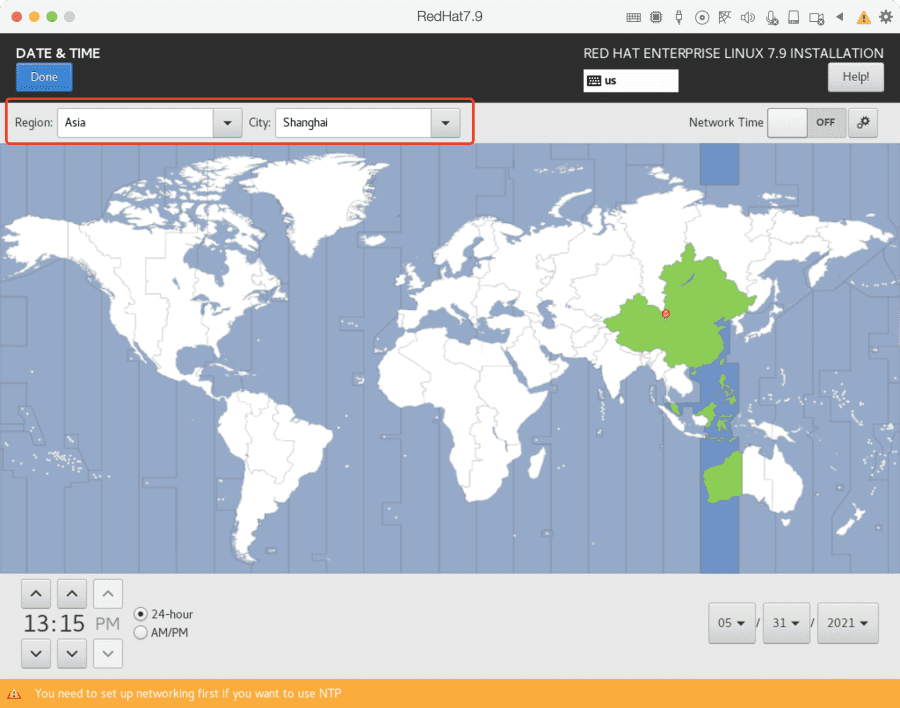

Linux

更多 >-

- 中级Linux改变文件目录权限chmod

-

1158次学习

收藏

-

-

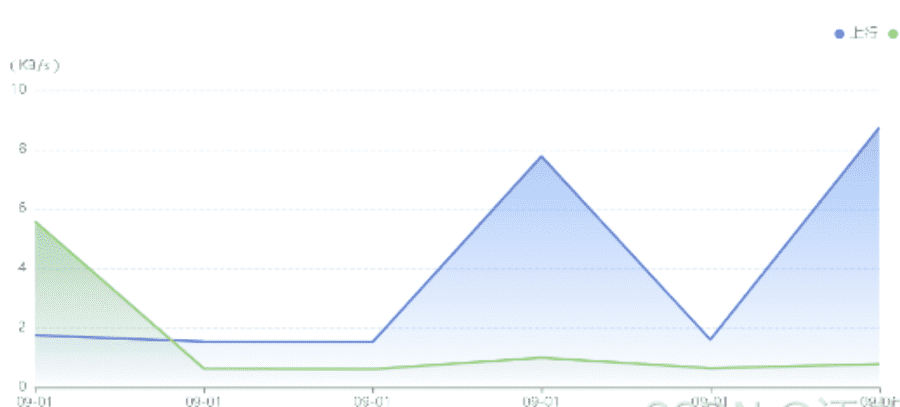

- 中级linux流量统计显示指定日期URL所有使用流量

-

1119次学习

收藏

-

- 中级linux如何分辨是否是虚拟机

-

1168次学习

收藏

-

-

-

- 中级mysql手机匹配查找

-

1197次学习

收藏

-

-

- 中级使用WebDAV来上传和下载文件

-

1002次学习

收藏

-

- 中级Linux如何查找文件

-

624次学习

收藏

PHP

更多 >-

-

- 高级php扩展开放PHP-CPP文档

-

1305次学习

收藏

-

- 高级VSCode一键删除空行、自动换行、删除全部注释

-

8982次学习

收藏

-

- 高级wireshark过滤规则有哪些

-

9063次学习

收藏

-

- 高级php数组转换为字符串

-

9570次学习

收藏

-

- 高级php如何去处数组的空元素

-

9654次学习

收藏

-

- 高级PHP文件处理与上传

-

9221次学习

收藏

-

-

- 高级PHP单引号和双引号的区别

-

8880次学习

收藏

-

最新文章

-

- 荐Databend SQL nom Parser 性能优化

-

25次学习

收藏

-

- 荐Databend SQL 存储过程使用指南

-

27次学习

收藏

-

-

-

- 荐实力担当,共筑智造新生态:禅道斩获WOD熵钥奖两项大奖

-

23次学习

收藏

-

-

- 荐从初识到实战 | OpenTeleDB 数据库线上征文活动

-

24次学习

收藏

-

-

-

资源下载

更多 >-

- 字符串过滤1.0.2

- 资源下载2025年2月20日 07:37:25

-

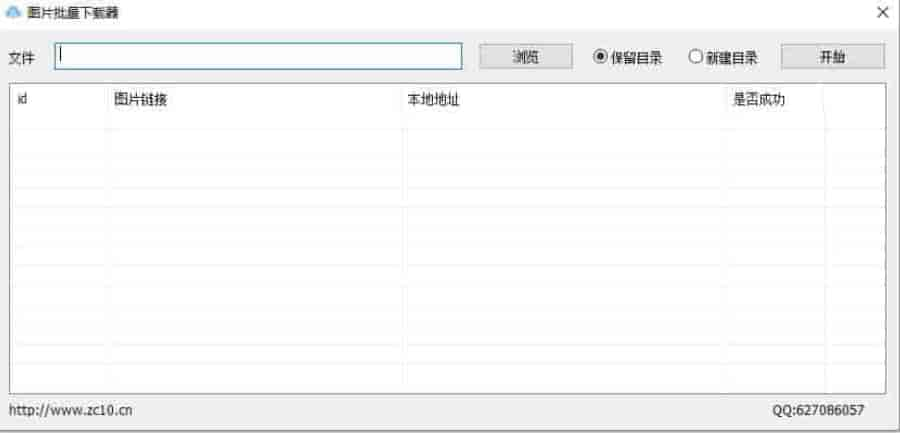

- 图片批量下载工具1.2

- 资源下载2025年2月20日 07:31:22

-

- 免费天龙八部自动材料加工

- 资源下载2025年2月20日 07:23:53

-

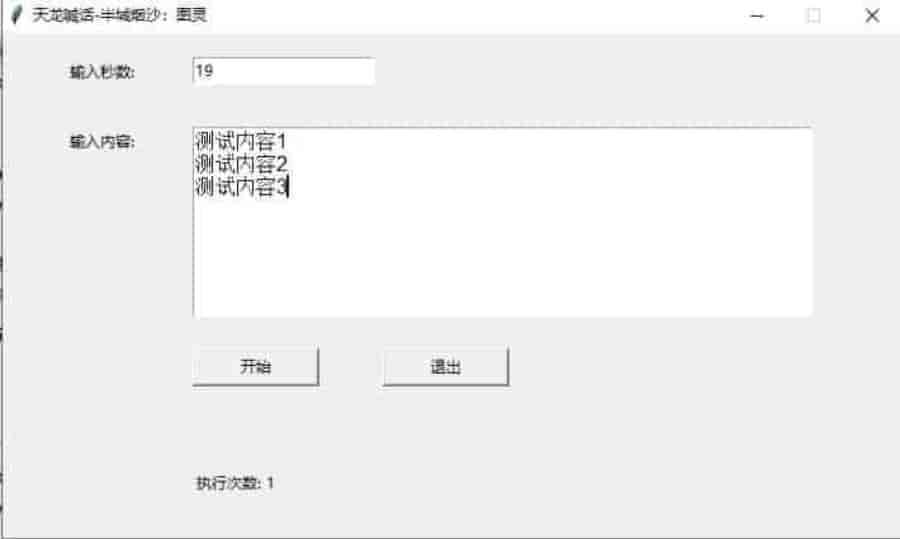

- 免费天龙八部自动喊话器

- 资源下载2025年2月20日 07:16:32

-

-

-

-

下载排行

- 1 免费邮箱群发器 13836下载

- 2 php8.0.1开发手册(2021官方)(CHM版) 11337下载

- 3 植物大战僵尸2010年度版辅助 10541下载

- 4 websocket测试工具,支持ws wss客户端 10419下载

- 5 免费PDF批量转换图片工具 9458下载

- 6 图片批量下载工具 9417下载

- 7 程序员加密解密工具 9356下载

- 8 IP批量定位 9120下载

- 9 字符串过滤 9103下载

- 10 字符串批量匹配 9080下载

技术文章

-

(二)3.1.9 生产“稳”担当:Apache DolphinScheduler Worker 服务源码全方位解析 原 荐

- (二)3.1.9 生产“稳”担当:Apache DolphinScheduler Worker 服务源码全方位解析 原 荐

- 科技 106 2025年9月25日 17:30:18

-

Ubuntu 22 下 DolphinScheduler 3.x 伪集群部署实录 原 荐

- Ubuntu 22 下 DolphinScheduler 3.x 伪集群部署实录 原 荐

- 科技 73 2025年9月19日 11:27:05

-

不增加 GPU,首 Token 延迟下降 50%|LLM 服务负载均衡的新实践

不增加 GPU,首 Token 延迟下降 50%|LLM 服务负载均衡的新实践

- 不增加 GPU,首 Token 延迟下降 50%|LLM 服务负载均衡的新实践

- 科技 83 2025年8月27日 10:32:33

-

鲲鹏软件全面开源:从 openEuler 到 BoostKit ,持续构建开放共赢的生态体系 原 荐

- 鲲鹏软件全面开源:从 openEuler 到 BoostKit ,持续构建开放共赢的生态体系 原 荐

- 科技 58 2025年10月14日 14:08:34

-

什么是上下文工程 (Context Engineering)?

什么是上下文工程 (Context Engineering)?

- 什么是上下文工程 (Context Engineering)?

- 科技 96 2025年9月12日 18:03:59

-

LazyLLM教程 | 第5讲:打造专属Reader组件:轻松解析HTML、PDF等复杂文档格式

LazyLLM教程 | 第5讲:打造专属Reader组件:轻松解析HTML、PDF等复杂文档格式

- LazyLLM教程 | 第5讲:打造专属Reader组件:轻松解析HTML、PDF等复杂文档格式

- 科技 107 2025年8月20日 15:24:39

-

探索智测新范式 | 2025 Gtest 全球软件测试技术峰会在北京盛大召开 原 荐

- 探索智测新范式 | 2025 Gtest 全球软件测试技术峰会在北京盛大召开 原 荐

- 科技 122 2025年9月05日 15:44:26

-

TinyEngine 2.8 正式上线:AI能力就位、Docker部署更高效! 原 荐

- TinyEngine 2.8 正式上线:AI能力就位、Docker部署更高效! 原 荐

- 科技 190 2025年9月03日 11:01:30

博客

-

-

9-18

专业电子章设计适用于平面设计,提高效率 - 了解Cookie 什么是Cookie?Cookie是在HTTP协议下,服务器或脚本可以维护客户工作站上信息的一种方式,是一种在远程浏览器端存储数据并并以此来跟踪和识别用户的机制。简单地说,Cookie是Web服务器暂时存储在用户硬盘上的一个文本文件,并随后被Web浏览器读取。Cookie的功能 记录访客的某些信息在页面之间传递变量将所查看的Internet...

- 推荐官 12 0

-

11-09

坚持 30 年,Netflix 联创马克・兰道夫每周二下午 5 点停止工作以保持“理智” - 了解Cookie 什么是Cookie?Cookie是在HTTP协议下,服务器或脚本可以维护客户工作站上信息的一种方式,是一种在远程浏览器端存储数据并并以此来跟踪和识别用户的机制。简单地说,Cookie是Web服务器暂时存储在用户硬盘上的一个文本文件,并随后被Web浏览器读取。Cookie的功能 记录访客的某些信息在页面之间传递变量将所查看的Internet...

- 推荐官 14 0

-

9-23

查理·柯克之死与美国大学的“文化战” - 了解Cookie 什么是Cookie?Cookie是在HTTP协议下,服务器或脚本可以维护客户工作站上信息的一种方式,是一种在远程浏览器端存储数据并并以此来跟踪和识别用户的机制。简单地说,Cookie是Web服务器暂时存储在用户硬盘上的一个文本文件,并随后被Web浏览器读取。Cookie的功能 记录访客的某些信息在页面之间传递变量将所查看的Internet...

- 推荐官 13 0

-

10-31

广州新地标“羊城花冠”T3航站楼惊艳亮相 - 了解Cookie 什么是Cookie?Cookie是在HTTP协议下,服务器或脚本可以维护客户工作站上信息的一种方式,是一种在远程浏览器端存储数据并并以此来跟踪和识别用户的机制。简单地说,Cookie是Web服务器暂时存储在用户硬盘上的一个文本文件,并随后被Web浏览器读取。Cookie的功能 记录访客的某些信息在页面之间传递变量将所查看的Internet...

- 推荐官 19 0

-

9-14

苹果还在画饼!这些安卓功能诞生好几年了iPhone还没上 - 了解Cookie 什么是Cookie?Cookie是在HTTP协议下,服务器或脚本可以维护客户工作站上信息的一种方式,是一种在远程浏览器端存储数据并并以此来跟踪和识别用户的机制。简单地说,Cookie是Web服务器暂时存储在用户硬盘上的一个文本文件,并随后被Web浏览器读取。Cookie的功能 记录访客的某些信息在页面之间传递变量将所查看的Internet...

- 推荐官 21 0

-

9-28

MBTI测试高考志愿填报参考,购买你的专属人格礼物 - 了解Cookie 什么是Cookie?Cookie是在HTTP协议下,服务器或脚本可以维护客户工作站上信息的一种方式,是一种在远程浏览器端存储数据并并以此来跟踪和识别用户的机制。简单地说,Cookie是Web服务器暂时存储在用户硬盘上的一个文本文件,并随后被Web浏览器读取。Cookie的功能 记录访客的某些信息在页面之间传递变量将所查看的Internet...

- 推荐官 14 0

-

最新动态

-

- For hottest news you have to pay a visit the web and on world-wide-web I found this website as a finest site for most up-to-date updates.

-

Live Draw Sdy Lotto 推荐于2个月前 (09-13)

IP:127.0.0.1

-

- 还是蛮不错的,引导初学者了解基本的。 最近我也在学习写博客,有空来看看我呀,一起互相学习。期待你的关注与支持

-

英特尔边缘计算社区 推荐于4年前 (2022-02-04)

IP:129.89.244.255

-

- 还是蛮不错的,引导初学者了解基本的。 最近我也在学习写博客,有空来看看我呀,一起互相学习。期待你的关注与支持

-

英特尔边缘计算社区 推荐于4年前 (2022-02-04)

IP:129.89.244.255

-

- 干货满满,很详细,写的太好了,等我考研完,一定拜读。

-

野猪佩奇 推荐于4年前 (2022-01-20)

IP:128.180.111.71

-

- 干货满满,很详细,写的太好了,等我考研完,一定拜读。

-

野猪佩奇 推荐于4年前 (2022-01-20)

IP:128.180.111.71

-

- 代码之路任重道远,愿跟博主努力习之。

-

阿里云开发者 推荐于4年前 (2022-01-17)

IP:2.56.8.0