维权提醒:如果你或身边的朋友近五年内因投顾公司虚假宣传、诱导交费导致亏损,别放弃!立即联系小羊维权(158 2783 9931,微信同号),专业团队帮你讨回公道!

<h2>导语</h2> 分布式集群限流是保障云服务高可用性的核心技术手段,其意义不仅在于防止系统过载,更是构建弹性架构、优化资源效率、实现业务可持续性的关键策略。未来,随着边缘计算和 Serverless 的普及,限流技术将进一步与底层基础设施深度融合,成为构建下一代高可用架构的核心基石。

腾讯云 TDMQ RabbitMQ Serverless 版作为一款极致弹性、高性能且高可靠的消息中间件,通过提供稳定低延迟的消息服务,助力企业实现系统异步解耦并高效应对海量消息堆积。然而,在高并发、大流量的实际业务中,如何科学分配资源、规避系统过载风险,已成为保障服务稳定性的关键。为此,腾讯云 TDMQ RabbitMQ Serverless 版引入了集群级别的分布式限流机制,通过动态调控集群的发送与消费速率,确保集群在高负载下仍能稳定运行。

本文将深度剖析腾讯云 TDMQ RabbitMQ Serverless 版的限流机制,涵盖限流策略设计、触发机制及底层实现逻辑。通过真实场景案例解析与实践指南,系统讲解如何通过客户端优化来降低限流影响,同时帮助客户精准掌握集群限流相关服务端配置技巧,有效规避因流控策略不当引发的业务中断风险,全面提升高并发场景下的系统稳定性与可靠性。

概要设计

分布式限流的必要性

资源瓶颈的不可预测性

在分布式系统中,单节点流量可能因负载均衡策略(如 Round-Robin)不均导致倾斜。例如,某台服务器因硬件故障触发重试风暴,流量突增300%,若无全局视角的限流,可能引发级联雪崩。

长尾延迟的放大效应

当某服务节点响应延迟升高(如磁盘刷写延迟增大),后续请求堆积导致线程池耗尽,触发上游重试,形成恶性循环。

突发流量冲击

秒杀活动、热点新闻等场景下,流量可能在毫秒级陡增数十倍。例如,某电商平台大促期间,订单服务 QPS 从5k飙升至80k,若未通过分布式限流拦截异常流量,核心计算资源将被瞬间打满,导致服务不可用。

TDMQ RabbitMQ Serverless 版限流规则

腾讯云 TDMQ RabbitMQ Serverless 版为超大规模、低时延、高可用性要求的在线业务提供专业级消息服务。客户端通过 RabbitMQ SDK 与 TDMQ RabbitMQ Serverless 版集群建立长连接,实现高效的消息收发操作,同时动态占用集群的计算、存储及网络带宽等关键资源。在此背景下,为确保消息服务的高性能与稳定性,在应对高并发、大流量场景时,必须对集群的负载水位进行精细化管理。 基于集群的资源配置上限,服务端支持动态调控客户端的每秒消息发送与消费能力(TPS),确保系统在高负载下依然保持稳定运行。

为实现资源隔离与灵活适配的双重目标,系统对发送消息与消费消息的 TPS 配额进行独立分配,并支持用户按需配置配额比例,从而实现精细化资源管理与业务场景的精准匹配(默认配额比例为1 : 1 也即50%)。业务可以根据实际的收发比例进行调整,可调整的收发消息比例范围在20%-80%(服务端支持动态调整该区间)之间。

TDMQ RabbitMQ Serverless 版限流行为

腾讯云 TDMQ RabbitMQ Serverless 版采用 Fail-Fast 限流机制,即当客户端请求速率触及预设上限时,服务端会即时返回错误响应。在响应时间敏感的在线业务场景中,该机制可使客户端实时感知限流事件并主动介入处理,从而有效避免因资源竞争导致的端到端时延长尾,保障业务连续性与系统稳定性。

以 1000TPS 规格的基础集群为例(假设收发 TPS 比例为1:1 也即50%),客户端视角下的限流行为:

| 说明 | 发送消息限流 | 消费消息限流 | | ———— | ———— | ———— | | 触发限流情景 | 所有连接该集群的发送客户端每秒最多可发送 TPS 总和为 500 条,发送速率达到限制后,超限的发送请求会失败。 | 所有连接该集群的消费客户端每秒最多可消费 TPS 总和为 500 条,消费速率达到限制后,消息的消费延迟会增加。 | | 触发限流时 SDK 日志关键词 | com.rabbitmq.client.AlreadyClosedException: channel is already closed due to channel error; protocol method: #method

详细设计与实现

架构设计

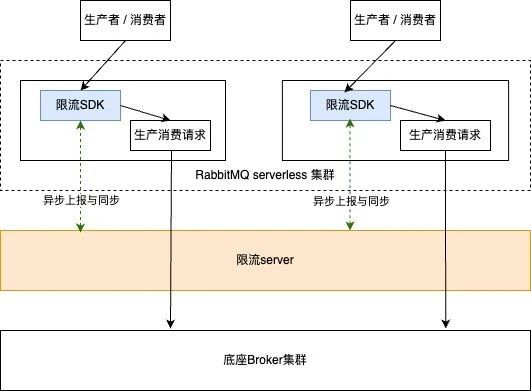

腾讯云 TDMQ RabbitMQ Serverless 版采用双模式限流架构,兼顾节点级保护与集群级协同:

单机限流(Node-Level Throttling)

用于节点级资源保护,通过限制 CPU、内存、线程等关键资源的使用,防止单节点因过载导致服务不可用。

分布式限流(Cluster-Level Throttling)

基于集群全局视角,通过多节点流量协同管理,保护共享存储资源(如 Broker)及后端系统稳定性。该模式通过使用分布式限流系统实现。

限流实现

腾讯云 TDMQ RabbitMQ Serverless 版通过在计算层 (TDMQ RabbitMQ Serverless 版集群)接入分布式限流系统实现集群级读写流量控制,其核心机制是:TDMQ RabbitMQ Serverless 版集群节点在处理 BasicPublish / BasicGet / DeliverMessage 请求前,需通过集成的限流 SDK 向限流 Server 异步上报与申请 Token。

生产端限流 :若 BasicPublish 申请失败,则立即拒绝生产消息请求并返回错误。 消费端限流:若 BasicGet 申请失败,则立即拒绝拉取消息请求并返回错误。若 DeliverMessage 申请失败,则抑制推送到消费者的消息速率,实现消费端不断连接的流控,此时类似于 RabbitMQ 开源的实现,此时该消费者处于 Flow 状态。

TDMQ RabbitMQ Serverless 版集群内部集成限流 SDK,该 SDK 提供 Token 申请 API,并负责与限流 Server 通信,通过这种集中式 Token 管理实现对核心存储层 (底座 Broker 集群) 的保护。

限流实现难点一:如何平衡性能与精度

使用 TDMQ RabbitMQ Serverless 版的各类在线业务通常对时延比较敏感,如果计算层节点处理每次读写请求都执行一次 Limiter RPC 调用(SDK -> Server)的话,虽然 Limiter Server 内部处理耗时几乎可以忽略,但两次 RPC 的网络 IO 耗时对消息端到端时延的影响是不能忽视的。

实际上从服务端的角度看, TDMQ RabbitMQ Serverless 版执行限流的主要目的是防止核心存储层过载,而非追求 100% 精准的流量控制,即 SDK 与 Server 之间的强同步并不是必须的。因此,为了在限流性能和限流精度之间取得平衡,Limiter 采用了一种【先消费后结算】的 Token 管理机制,Token 申请过程在限流 SDK 内部闭环,SDK 会周期性(周期大概在50ms以内,上报周期越短,限流越敏感)地向限流 Server 异步上报 Token 使用量并同步配额。

腾讯云 TDMQ RabbitMQ Serverless 版的限流机制通过以下四大核心特性,在保障系统稳定性的同时实现高性能与低时延的平衡:

- 内存级处理,主链路零干扰

执行机制:限流判断为纯内存操作,不涉及外部 RPC 调用,确保消息处理流程完全不受阻塞。

性能优势:主链路延迟无感知,适用于对响应时间要求严苛的在线业务场景。

- 先消费后结算,消除误限流风险

设计原理 :采用异步 Token 核销机制,客户端可先执行操作,限流 SDK 后续异步周期性同步配额消耗。 效果保障:杜绝因限流判断延迟导致的正常请求被误拒,确保业务连续性。

- 短暂超限容忍,资源缓冲池兜底

场景说明 :在流量毛刺等突发场景中,可能出现瞬时配额超限,由于先消费后结算的机制导致。 容错机制:通过服务端资源预留 Buffer 吸收流量波动,避免因短暂超限触发系统风险。

- 弹性容错设计,弱耦合架构保障可用性

故障降级策略 :当限流 Server 服务异常时,系统自动切换至单机 Sentinel 组件实现基础单机限流功能。 依赖特性:对限流 Server 服务实现弱耦合架构,可以通过随时动态降级来避免限流 Server 服务异常导致的服务异常,确保分布式限流服务的高可用。

限流实现难点二:如何平滑限流毛刺

腾讯云 TDMQ RabbitMQ Serverless 版采用 TPS 作为集群规格单位,用于衡量集群的吞吐能力。例如,1000TPS 表示集群每秒可处理 1000 条 TPS(即综合生产、消费等操作的加权计算)。在分布式限流系统中,这一规格对应每秒分配 1000 个 Token,其中 “一秒”即为默认的限流计数周期,用于动态控制流量配额。

在使用限流服务的实际运维中发现:

短周期(如1秒): 优势:对流量波动敏感,可快速响应潜在过载风险; 缺陷:易因短暂毛刺误触限流,影响正常业务波动场景。

长周期(如10秒): 优势:容忍毛刺,降低误控率; 缺陷:服务端资源需承受更高瞬时冲击风险。

为平衡流量控制精度与用户体验,腾讯云 TDMQ RabbitMQ Serverless 版将默认限流计数周期从1秒调整为10秒。这样既降低了用户因毛刺导致的限流困扰,又通过利用少量的服务器预留资源 Buffer 来承载瞬时流量冲击,为高并发场景下的消息处理提供了可靠的支撑。

限流实现难点三:如何实现消费端限流

腾讯云 TDMQ RabbitMQ Serverless 版集群使用 AMQP 协议与客户端交互,然而 AMQP 协议中并没有定义很好的处理 Fail-Fast 限流错误的帧,因此在发送消息被限流的情况下,只能通过关闭 Channel 连接来通知到客户端,此时客户端会收到相应的 AlreadyClosedException 异常,然后业务需要通过重试来解决当前时间窗口内消息发送被限流的问题。

而在消费端限流的情况下,分为两种情况,AMQP 协议中支持两种消费模式,BasicGet(拉模式) 和 BasicConsume(推模式)。 此时对消费端的限流就需要考虑消费的连续性和延迟。针对 BasicGet 模式,是客户端发起的主动同步拉取消息的命令,此时客户端每一次拉取消息是可以直接感知到是否被限流的,更好的方式是通过关闭连接来让客户端感知到限流,从而让业务上通过重试来解决拉取当前时间窗口内消息消费被限流的问题。

但是针对 BasicConsume(推模式), 同时也是 AMQP 客户端最普遍的使用方式,考虑到客户端开启一个长连接监听相应队列上的消息,此时如果因为限流粗暴地关闭 Channel 连接, 此时的客户端往往不能实时感知到连接 Channel 断开,增加了客户端业务上处理的复杂度,同时消费侧重建 Channel 连接也会让消费流量充满毛刺和消费延迟增加。因此腾讯云 TDMQ RabbitMQ Serverless 版在推模式下使用消费抑制的方式来实现消费端限流,当消费 TPS 超过阈值时,会减少推送到客户端的频率,保证了在连接 Channel 不断开的情况下,消费流量的平稳,尽量减少因为限流导致的消费延迟。

客户端实践教程

规划集群限流负载

腾讯云 TDMQ RabbitMQ Serverless 版的限流机制旨在保障服务稳定性与可靠性。防止在集群高负载时出现服务响应长尾毛刺,最终导致请求成功率下降,业务受损等问题。因此,在接入时建议:客户侧需要提前规划集群负载,依据当前规模和未来趋势预测来充分评估业务 TPS, 如果业务流量具有波动特性,应以峰值 TPS 为准,根据相应的评估后的 TPS 购买相应规格的实例集群。

限流相关告警配置

腾讯云 TDMQ RabbitMQ Serverless 版默认接入了腾讯云监控的能力,可以利用腾讯云 TDMQ RabbitMQ Serverless 版控制台的监控告警能力实现对集群负载的实时观测,提前发现 TPS 水位风险并及时操作升配来避免触发限流导致业务受损。告警策略建议:

- 发送和消费 TPS 水位超过容量的 70% 时触发告警,提醒进行升配评估。

- 出现发送限流时触发告警,警告业务发送消息可能失败风险。

客户端限流异常处理

业务代码通过 RabbitMQ SDK 发送消息时,需要捕获包括限流错误在内的异常,并保存必要的上下文信息,以便人工介入恢复业务。当腾讯云 TDMQ RabbitMQ Serverless 版实例的 TPS 流量峰值超过腾讯云控制台所购买实例的 TPS 规格上限时,业务侧生产消费流量会被限流。

限流后的行为如下:

腾讯云 TDMQ RabbitMQ Serverless 版服务端会返回错误码信息。

腾讯云 TDMQ RabbitMQ Serverless 版服务端关闭当前请求的 Channel 连接,代码中可以捕获异常并重新打开 Channel 连接,具体请参见错误码处理示例代码章节。

错误码信息: 错误码:reply-code=530

错误信息:reply-text=[requestId: 3143682333552716694] Action: pub rate limited by cluster on instance:xxx reason:PublishMessage, class-id=60, method-id=40)

错误堆栈:

Suppressed: com.rabbitmq.client.AlreadyClosedException: channel is already closed due to channel error; protocol method: #method<channel.close>(reply-code=530, reply-text=[requestId: 3143682333552716694] Action: pub rate limited by cluster on instance:amqp-autotest reason:PublishMessage, class-id=60, method-id=40)

at com.rabbitmq.client.impl.AMQChannel.processShutdownSignal(AMQChannel.java:437)

at com.rabbitmq.client.impl.ChannelN.startProcessShutdownSignal(ChannelN.java:295)

at com.rabbitmq.client.impl.ChannelN.close(ChannelN.java:624)

at com.rabbitmq.client.impl.ChannelN.close(ChannelN.java:557)

at com.rabbitmq.client.impl.ChannelN.close(ChannelN.java:550)

at com.rabbitmq.client.impl.recovery.AutorecoveringChannel.lambda$close$0(AutorecoveringChannel.java:74)

at com.rabbitmq.client.impl.recovery.AutorecoveringChannel.executeAndClean(AutorecoveringChannel.java:102)

at com.rabbitmq.client.impl.recovery.AutorecoveringChannel.close(AutorecoveringChannel.java:74)

RabbitMQ AMQP Java SDK 业界使用的比较广泛,因此使用该 SDK 作为示例,RabbitMQ AMQP Java SDK 不会对限流错误进行自动重试,因此业务代码需要捕获异常并进行处理,示例代码如下:

private static final int MAX_RETRIES = 5; // 最大重试次数

private static final long WAIT_TIME_MS = 2000; // 每次重试的等待时间(以毫秒为单位)

private void doAnythingWithReopenChannels(Connection connection, Channel channel) {

try {

// ......

// 在当前通道channel下执行的任何操作

// 例如消息发送、消费等

// ......

} catch (AlreadyClosedException e) {

String message = e.getMessage();

if (isChannelClosed(message)) {

// 如果通道已经关闭,关闭并重新创建通道

channel = createChannelWithRetry(connection);

// 在重连后可以继续执行其它操作

// ......

} else {

throw e;

}

}

}

private Channel createChannelWithRetry(Connection connection) {

for (int attempt = 1; attempt <= MAX_RETRIES; attempt++) {

try {

return connection.createChannel();

} catch (Exception e) {

System.err.println("Failed to create channel. Attempt " + attempt + " of " + MAX_RETRIES);

// 检查错误, 若仍是被限流导致的关闭错误,则可以等待后继续重试

// 也可移除本部分重试逻辑

if (attempt < MAX_RETRIES) {

try {

Thread.sleep(WAIT_TIME_MS);

} catch (InterruptedException ie) {

Thread.currentThread().interrupt(); // 还原中断状态

}

} else {

throw new RuntimeException("Exceeded maximum retries to create channel", e);

}

}

}

throw new RuntimeException("This line should never be reached"); // 理论上不会到达这里

}

private boolean isChannelClosed(String errorMsg) {

// 判断是否包含channel.close报错,该报错代表通道已关闭。

// 可能涵盖530,541等错误信息。

if (errorMsg != null && errorMsg.contains("channel.close")) {

System.out.println("[ChannelClosed] Error details: " + errorMsg);

return true;

}

return false;

}

总结

腾讯云 TDMQ RabbitMQ Serverless 版通过分布式限流架构为在线业务提供高可用的消息服务保障。在分布式限流模式下,服务端通过集中式 Token 管理系统(限流Limiter)动态分配资源配额,防止因突发流量冲击导致核心存储层(底座 Broker 集群)过载来提高系统稳定性,同时采用 【先消费后结算】的异步处理模式,客户端在限流 SDK 内部闭环完成 Token 申请,避免阻塞主链路,确保限流调用接口低延时,限流 SDK 周期性同步 Token 消耗数据至限流 Server,最终平衡了限流精度与调用限流服务的性能开销。同时针对消费端的限流可以实现不断 Channel 连接,实现了消费端在限流毛刺与消费延迟之间的双重保证,此外,面对限流 Server 服务不可用的情况,系统能够自动动态降级为单机限流模式,确保客户端请求的连续性,保持对限流服务的弱依赖设计来实现系统解耦。

在实际应用与运维中,同时也需要客户业务方的配合,在接入腾讯云 TDMQ RabbitMQ Serverless 版服务时,业务方客户需要根据业务规模和未来趋势合理规划集群,预留足够的 TPS 配额以应对突发流量,防患于未然。同时腾讯云 TDMQ RabbitMQ Serverless 版提供了服务端完善的监控和告警,支持客户通过监控告警能力实时订阅集群负载,提前发现 TPS 水位风险并及时进行升配等操作。在客户端业务代码层面,需要捕获限流异常并处理,保证代码的健壮性,同时保存必要的上下文信息,以便人工查看相关日志最终介入来恢复业务。

通过本文对腾讯云 TDMQ RabbitMQ Serverless 版的限流机制的介绍与实践教程,相信读者对腾讯云 TDMQ RabbitMQ Serverless 版的限流机制有了更深入的理解,并能够在实际项目中灵活应用,最终为业务的高并发、大流量场景提供稳定的支持。

</div>